Intelligence artificielle

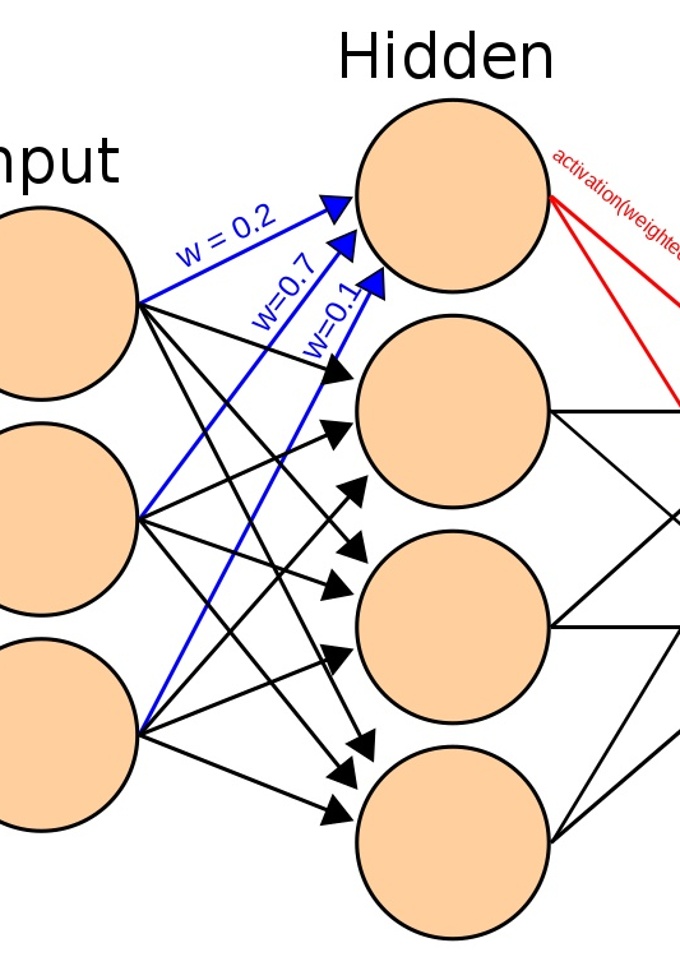

1943: Réseaux de neurones artificiels

Les scientifiques Warren S. McCulloch et Walter H. Pitts ont publié un texte révolutionnaire, "A Logical Calculus of the Ideas Immanent in Nervous Activity", devenu une référence fondamentale dans les réseaux neuronaux artificiels. Malgré une simplification des neurones par rapport aux biologiques, leur architecture pour l'intelligence a été optimisée par les chercheurs ultérieurs, jouant un rôle crucial en intelligence artificielle.

1950: Test de Turing

Le test de Turing est un test d'intelligence artificielle visant à déterminer si, par le biais d'une conversation en ligne, un ordinateur peut convaincre un humain qu'il est humain. Il consiste à mettre en communication, à l'aveugle, une personne avec deux interlocuteurs : un autre humain et une intelligence artificielle. Si le candidat ne parvient pas à faire la différence entre l'homme et la machine, alors on considère que cette dernière passe le test de Turing avec succès.

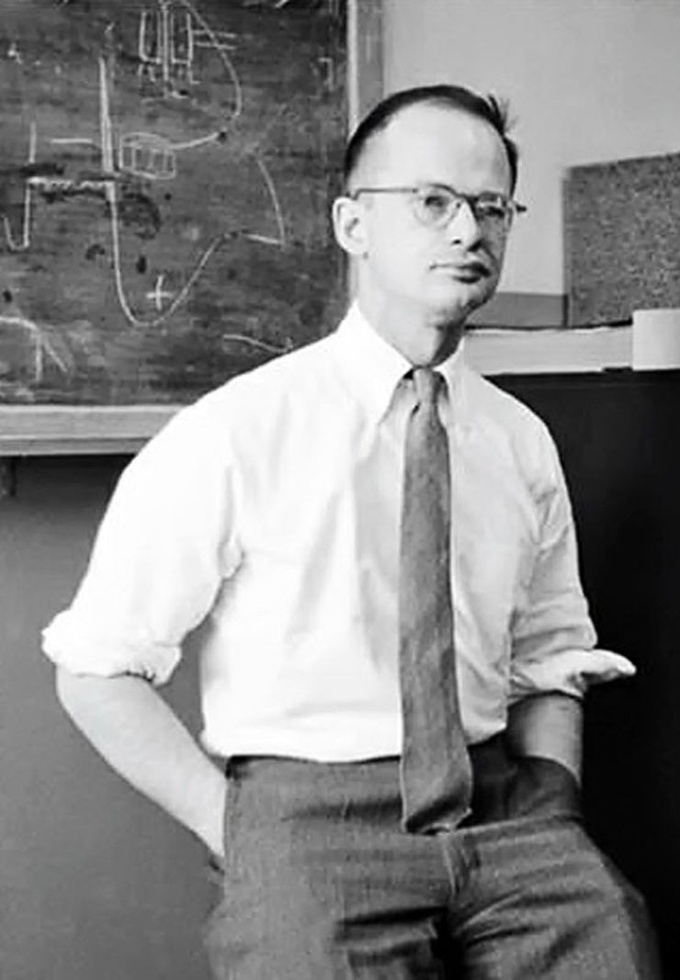

1958: Apprentissage avec réseau de neurones

Le premier algorithme d’apprentissage à l’aide de réseaux de neurones artificiels a été proposé par Franck Rosenblatt en 1958 et sa convergence a été démontrée en 1962 par Novikoff. Cet algorithme ajuste les paramètres du neurone artificiel d’un perceptron en fonction des erreurs de prédiction commises par le modèle afin de créer un classifieur binaire, c'est-à-dire un algorithme qui classe des données en deux catégories distinctes.

1965: Système expert DENDRAL

Créé au MIT dès 1965 et spécialisé en chimie moléculaire, DENDRAL est le premier système expert. Un tel système est basé sur un « moteur d’inférence », qui est programmé pour être un miroir logique d’un raisonnement humain. En entrant des données, le moteur fournit ainsi des réponses d’un haut niveau d’expertise. L’avènement des microprocesseurs fin 1970, entraînera un engouement pour les systèmes experts dans les années 1980, qui retombera par la suite du fait de leur complexité et de leur coût.

1997: Un ordinateur bat le champion du monde d’échecs

En mai 1997 de Deep Blue, système expert d’IBM, bat au jeu d’échec Garry Kasparov, champion du monde de l’époque. Le fonctionnement de Deep Blue s’appuyait sur un algorithme systématique de force brute, où tous les coups envisageables étaient évalués et pondérés. Cette défaite de l’humain est restée très symbolique dans l’histoire, mais sera le chant du cygne des systèmes experts dont les financements et les développements s’amenuiseront.

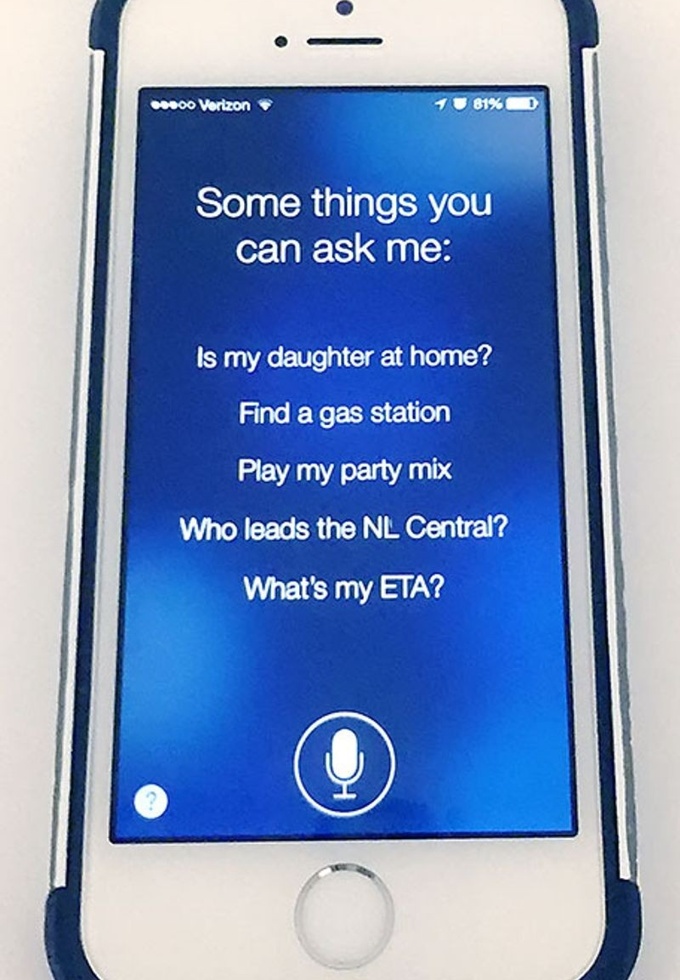

2011: Siri est annoncé

Siri est une intelligence artificielle, vocale, et un assistant virtuel, développée par Apple. Siri comprend les instructions verbales données par les utilisateurs et répond à leurs requêtes. L'interface homme-machine de Siri repose sur la reconnaissance vocale avancée, le traitement du langage naturel (oral) et la synthèse vocale.

2012: Une I.A. reconnaît des chats

En 2012, Google X (laboratoire de recherche de Google) arrivera à faire reconnaître à une IA des chats sur une vidéo. Pour la première fois, une machine arrive à apprendre à distinguer quelque chose. Cette prouesse a été rendue possible par la puissance de calcul (plus de 16 000 processeurs ont été utilisés) et l’accès massifs aux données grâce à internet qui permet de facilement trouver des millions de photos de chats avec les moteurs de recherche.

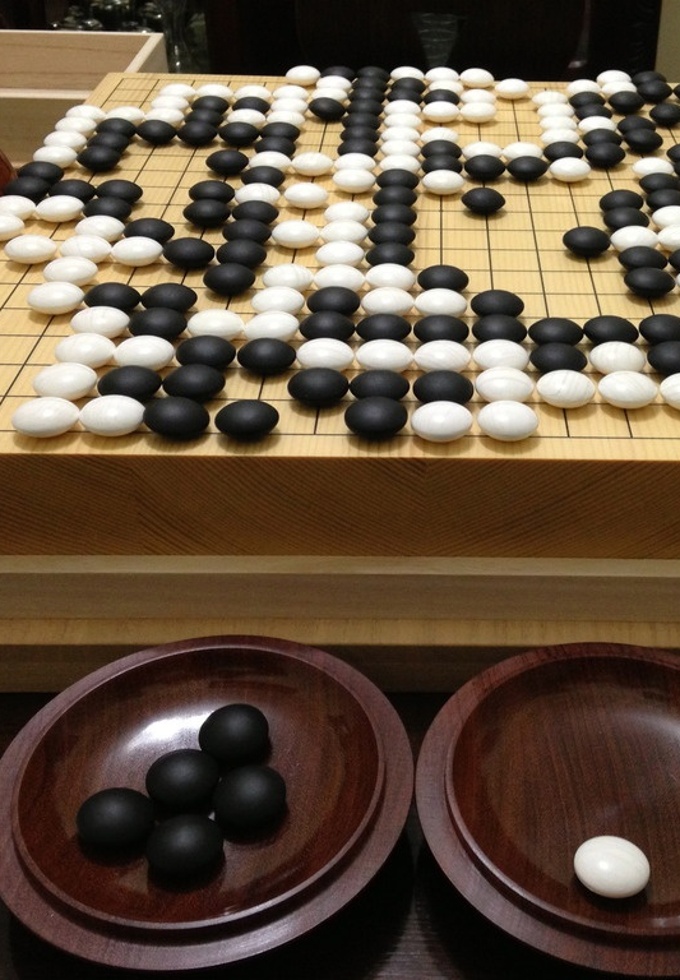

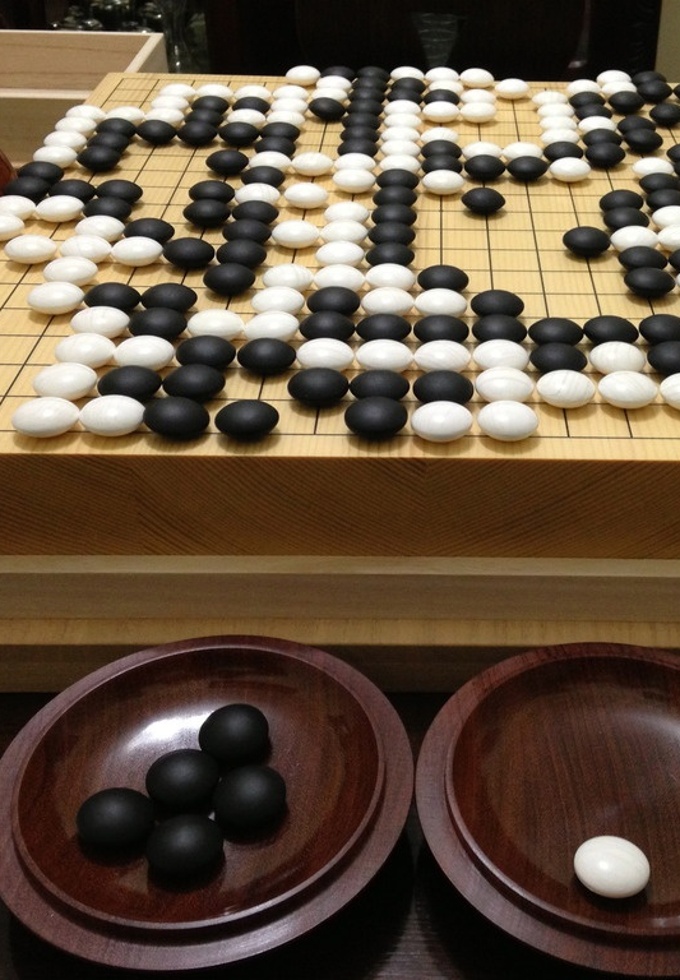

2017: AlphaZero

AlphaZero est le premier logiciel reposant uniquement sur l’auto-apprentissage qui a surpassé tous les joueurs humains et logiciels aux Go et aux échecs. A l’aide d’un réseau de neurones artificiels et des seules règles des échecs, il a appris à jouer en faisant 44 millions de parties contre lui-même en 4 heures et a battu largement (28 victoires, 72 nuls, 0 défaites). Stockfish le logiciel champion du monde qui surpassait largement les grands maîtres depuis des années.

2022: ChatGPT

ChatGPT, est un agent conversationnel (chatbot) utilisant l'intelligence artificielle, lancé fin 2022 par OpenAI. Il est capable de répondre à des questions, de tenir des conversations, de générer du code informatique, et d'écrire, traduire ou synthétiser des textes. Il peut le faire en tenant compte du contexte, et de contraintes telles que le style d'écriture. Ses réponses articulées et sa capacité à traduire des textes sont particulièrement remarquées.

Algorithmes

-2500: Tablette sumérienne

Les premières preuves d’algorithmes se trouvent dans les mathématiques babyloniennes de l’ancienne Mésopotamie (Irak moderne). Une tablette d'argile sumérienne trouvée à Shuruppak près de Bagdad a décrit le premier algorithme de division.

-300: Algorithme d’Euclide

L'algorithme d'Euclide est l'un des plus anciens algorithmes. Il est décrit dans le livre X (Proposition 2), pour un problème de façon géométrique : comment trouver une « unité de mesure » commune pour deux longueurs de segments. Il procède par soustractions répétées de la longueur du plus court segment sur la longueur du plus long.

IXe siècle

: Al-KhwârizmîMuḥammad ibn Mūsā al-Khwārizmī, généralement appelé Al-Khwârizmîn (latinisé en Algoritmi ou Algorizmi), né dans l'actuel Ouzbékistann est un mathématicien, géographe, astrologue et astronome persan. On lui doit l'utilisation des chiffres arabes et leur diffusion dans leMoyen-Orient et en Europe. Al-Khawarizmi a classifié les algorithmes existants, en particulier selon leurs critères de terminaison, mais ne les a pas inventés.

1842: Ada Lovelace

Ada Lovelace, comtesse de Lovelace, née à Londres est une pionnière de la science informatique. Elle est principalement connue pour avoir réalisé le premier véritable programme informatique, lors de son travail sur un ancêtre de l'ordinateur : la machine analytique de Charles Babbage. Dans ses notes, on trouve en effet le premier programme publié, destiné à être exécuté par une machine, ce qui fait d'Ada Lovelace la première personne à avoir programmé au monde.

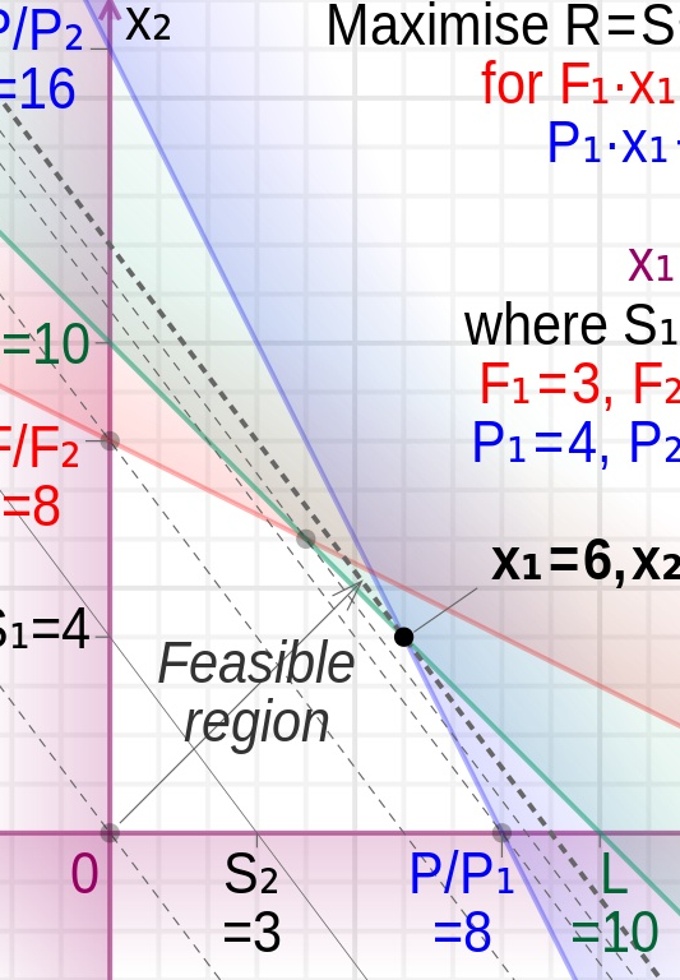

1947: Optimisation linéaire

L’optimisation linéaire consiste à minimiser une fonction linéaire sur un ensemble défini par des inégalités. L’algorithme du simplexe est le premier de ce type. Il a été introduit par George Dantzig pendant la 2e guerre mondiale et a joué un rôle crucial pour l’approvisionnement des armées alliées, puis publié en 1947. Très efficaces pour résoudre des problèmes de planification et de distribution, ces algoithmes sont ceux qui ont eu d’importants impacts économiques.

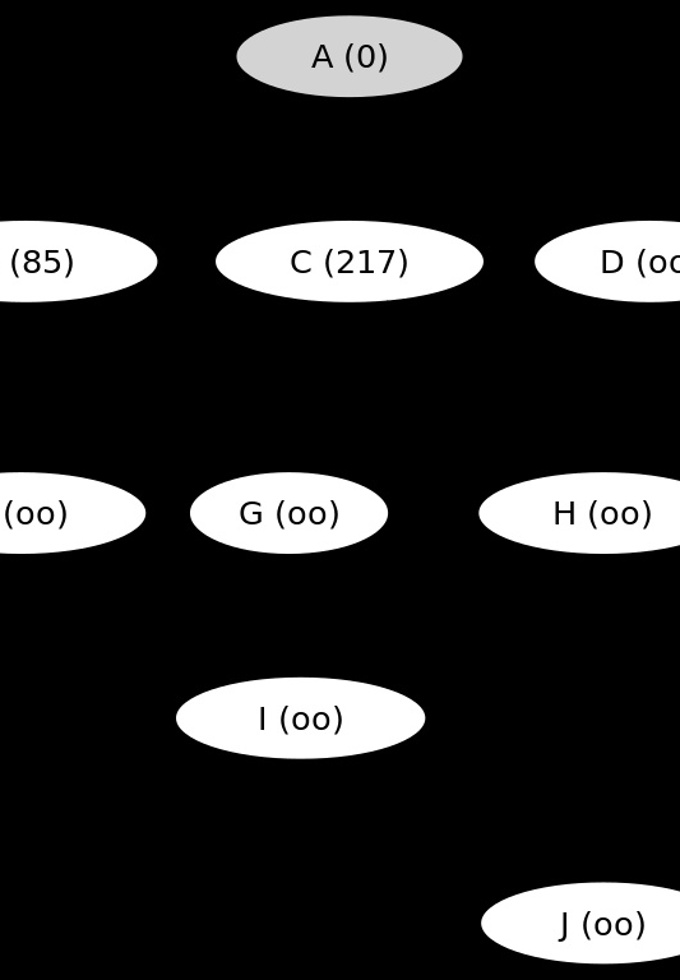

1956: Algorithme de Dijkstra

En théorie des graphes, l'algorithme de Dijkstra (prononcé [dɛɪkstra]) sert à résoudre le problème du plus court chemin. Il permet, par exemple, de déterminer un plus court chemin pour se rendre d'une ville à une autre connaissant le réseau routier d'une région. L'algorithme porte le nom de son inventeur, l'informaticien néerlandais Edsger Dijkstra.

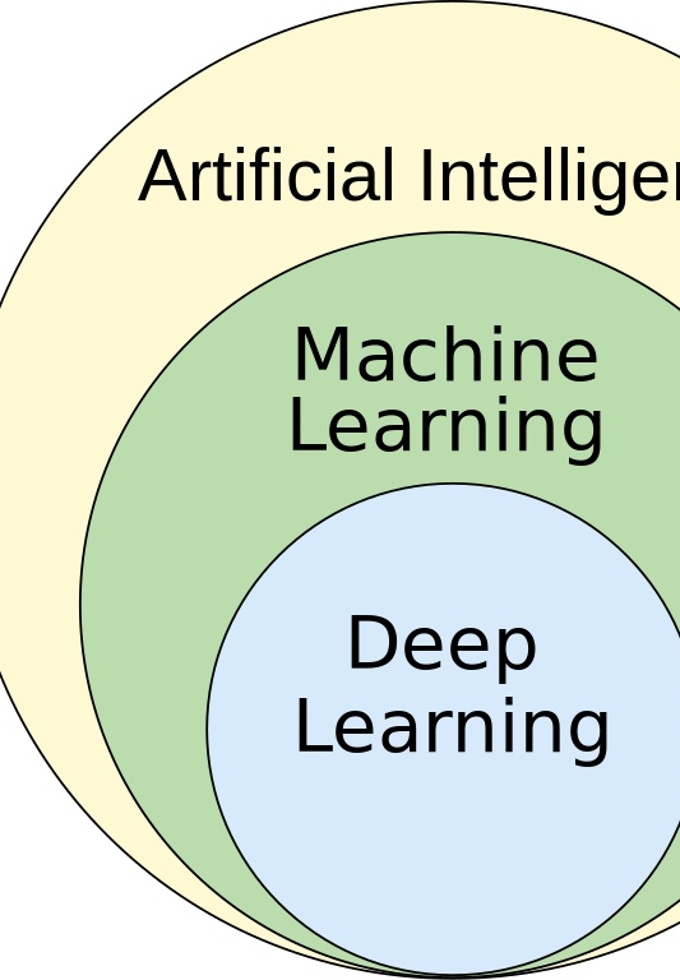

1959: Apprentissage automatique

L'apprentissage automatique(en anglais : machine learning), est un champ d'étude de l'intelligence artificielle qui se fonde sur des approches statistiques pour donner aux ordinateurs la capacité d'« apprendre » à partir de données. Arthur Samuel, informaticien américain est le premier à faire usage de l'expression machine learning à la suite de la création de son programme qui jouait au Jeu de Dames et s'améliorait en jouant. Ce programme parvint à battre le 4e meilleur joueur des USA.

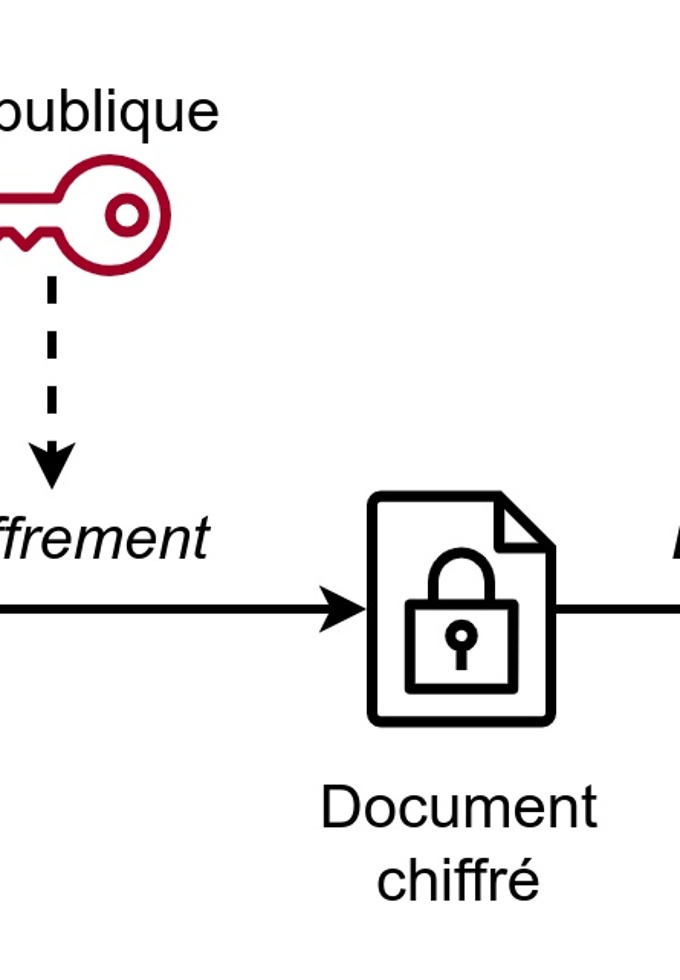

1977: Chiffrement RSA

Le chiffrement RSA (nommé par les initiales de ses trois inventeurs) est un algorithme de cryptographie asymétrique, très utilisé dans le commerce électronique, et plus généralement pour échanger des données confidentielles sur Internet. Le chiffrement RSA est asymétrique : il utilise une paire de clés (des nombres entiers) composée d'une clé publique pour chiffrer et d'une clé privée pour déchiffrer des données confidentielles.

1991: Compression JPEG

JPEG définit le format d'enregistrement et l'algorithme de décodage pour une représentation numérique compressée d'une image fixe. JPEG définit deux classes de compression : avec pertes ou compression irréversible. C’est le JPEG « classique ». Il permet des taux de compression de 3 à 100. Sans pertes ou compression réversible. Il n’y a pas de pertes d’information et il est donc possible de revenir aux valeurs originales de l’image. Le taux de compression est de l’ordre de 2 à 8 seulement.

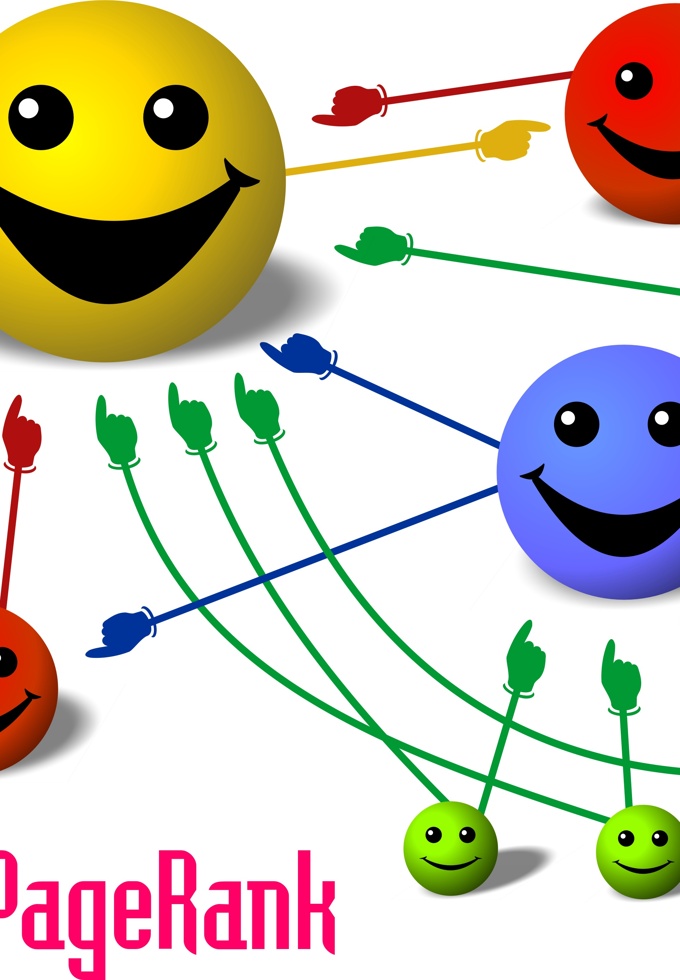

1996: Algorithme PageRank

Le PageRank ou PR est l'algorithme d'analyse des liens concourant au système de classement des pages Web utilisé par le moteur de recherche Google. Il mesure quantitativement la popularité d'une page web. Le PageRank n'est qu'un indicateur parmi d'autres dans l'algorithme qui permet de classer les pages du Web dans les résultats de recherche de Google. Ce système a été inventé par Larry Page, cofondateur de Google.

2017: AlphaZero

AlphaZero est le premier logiciel reposant uniquement sur l’auto-apprentissage qui a surpassé tous les joueurs humains et logiciels aux Go et aux échecs. A l’aide d’un réseau de neurones artificiels et des seules règles des échecs, il a appris à jouer en faisant 44 millions de parties contre lui-même en 4 heures et a battu Stockfish le logiciel champion du monde qui surpassait largement les grands maitres depuis des années.

Graphisme et jeux vidéos

1952: Alexander Douglas écrit OXO pour EDSAC

Alexander Douglas, doctorant à l'Université de Cambridge, a créé l'un des premiers jeux informatiques, OXO, une version de Tic-Tac-Toe, sur l'ordinateur EDSAC. Jouable sur un tube cathodique, le joueur pouvait choisir de commencer ou laisser la machine faire le premier mouvement. Utilisant un cadran rotatif pour les mouvements, OXO a eu un impact limité en dehors de Cambridge.

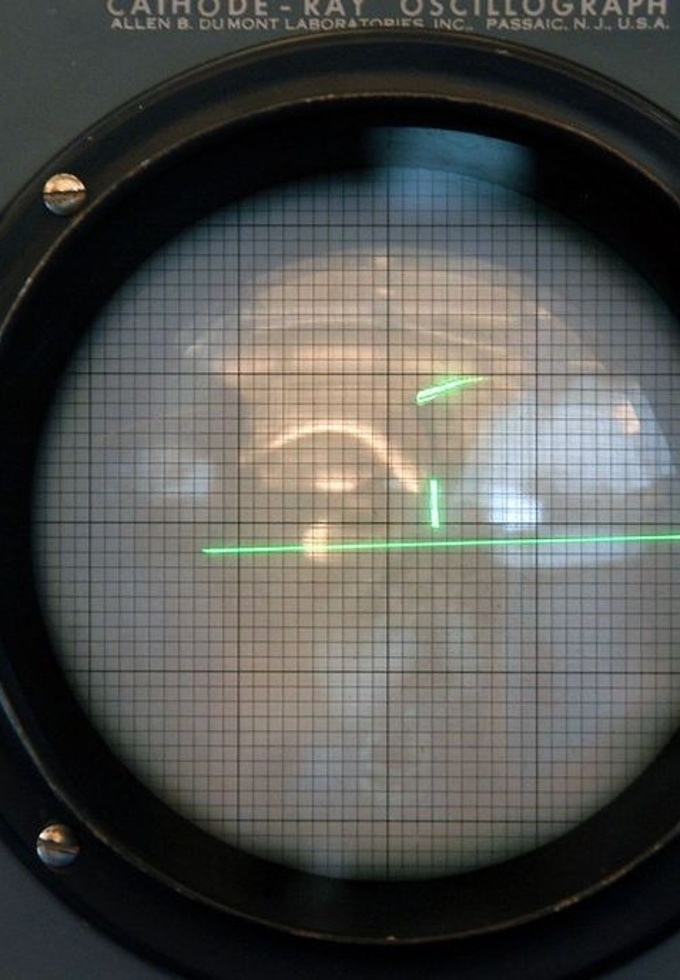

1958: Tennis-For-Two

Le Brookhaven National Laboratory de Long Island, à New York, organise une journée annuelle pour les familles et les résidents de la région. William Higinbotham, à la recherche d'un moyen de divertir les visiteurs, a conçu un simple jeu électronique qui pourrait être joué à l'aide de l'ordinateur analogique Donner Model 30 du laboratoire connecté à un écran oscilloscope.

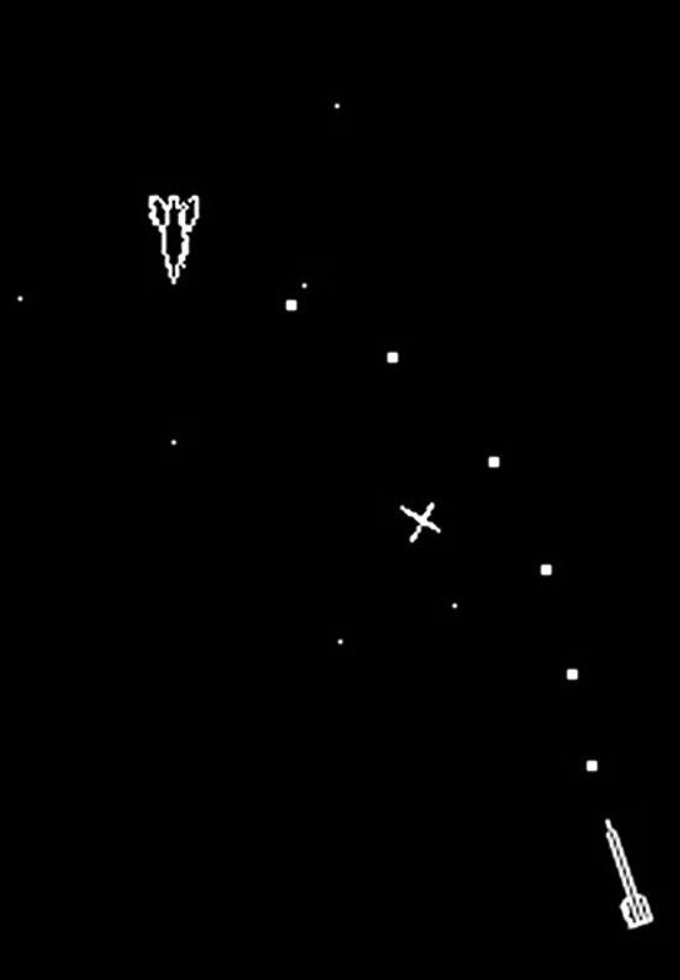

1962: Spacewar

Le MIT acquiert un ordinateur DEC PDP-1. Pour présenter ses capacités, ils créent Spacewar!, un jeu de combat spatial inspiré des romans Lensman de E.E. "Doc" Smith. Deux vaisseaux, le « Wedge » et le « Needle », évoluent dans un espace étoilé généré par un programme. Le jeu est diffusé via DECUS, le groupe d'utilisateurs de Digital Equipment Corporation, assurant ainsi une large adoption dans les milieux informatiques techniques et universitaires.

1972: Pong sur arcade

Entrepreneur de Californie Nolan Bushnell engage le jeune ingénieur Al Alcorn pour concevoir un jeu de conduite automobile, mais lorsqu'il devient évident que c'est trop ambitieux pour l'époque, Alcorn conçoit plutôt une version de Ping Pong. Le jeu a été testé dans des bars à Grass Valley et Sunnyvale, en Californie, où il s'est avéré très populaire. Pong révolutionnerait l'industrie de l'arcade et lancerait l'ère moderne du jeu vidéo.

1982: Lucasfilm produit l'effet Genesis pour Star Trek II

Le film Star Trek II présente l'une des premières séquences d’images de synthèse. Réalisé par le groupe d'infographie de Lucasfilm, inspiré par les simulations de vol de Jupiter et Saturne de Jim Blinn pour la NASA, la séquence montre la renaissance d'une planète grâce à un «ring de vie» généré par ordinateur. Réalisée avec deux ordinateurs DEC VAX, la séquence est un classique de l'animation informatique et a nécessité deux années-personnes de travail pour être achevée.

1992: Norme JPEG finalisée

Un groupe d'organisations internationales de normalisation a créé un groupe mixte d'experts photographiques (JPEG) pour créer un ensemble de normes pour les images numériques. La compression Jpeg permet un compromis entre la qualité de la photo et la taille du fichier. Jpeg est l'un des formats d'image les plus populaires, et est le format le plus largement utilisé par les appareils photo numériques.

2004: World of Warcraft est en ligne

Après dix ans comme une série de jeux de stratégie, Blizzard Entertainment lance World of Warcraft, une version massive multijoueur jeu de rôle en ligne (MMORPG) de leur populaire franchise Warcraft. Au centre de l'univers fantastique d'Azéroth, Warcraft permet aux joueurs de choisir un avatar pour aller à la conquête. Les joueurs forment des guildes et des parties de raid, ainsi que des connexions sociales fortes, et même romantiques, grâce à la fonction de chat intégrée.

2013: Microsoft présente Xbox One

Microsoft n'avait pas publié une nouvelle version de la Xbox depuis près de huit ans. L'interface utilisateur basée sur les mouvements de Kinect et les options de divertissement en streaming telles que Xbox Music et Xbox Video ont constitué une partie importante du nouveau système. Des jeux ont été proposés via des disques Blu-ray, ou par téléchargement depuis le service Xbox Live de Microsoft. Contrairement à la concurrence elle n'offrait aucune compatibilité arrière pour les jeux Xbox antérieurs.

2020: Pénurie de cartes graphiques

La crise des semi-conducteurs se produisant durant la pandémie du COVID-19 touche de nombreux secteurs industriels notamment celui des cartes graphiques et des consoles de jeu vidéo particulièrement gourmandes de ces matériaux. L'utilisation de cartes graphiques dans d’autres domaines que le jeu vidéo tels que l’intelligence artificielle ou le minage de cryptomonnaie rend l'acquisition de cartes graphiques récentes presque impossible.

Matériel

-5000: Boulier

Le boulier est l'un des premiers instruments de calcul utilisés par l'homme. Son origine précise est difficile à déterminer, mais on estime généralement que les premiers bouliers ont été utilisés il y a environ 5000 ans en Mésopotamie. Les bouliers permettent d'effectuer les quatre opérations : additions, soustractions, multiplications et divisions ainsi que l'extraction de racine carrée, l'extraction de racine cubique et la conversion entre différentes bases.

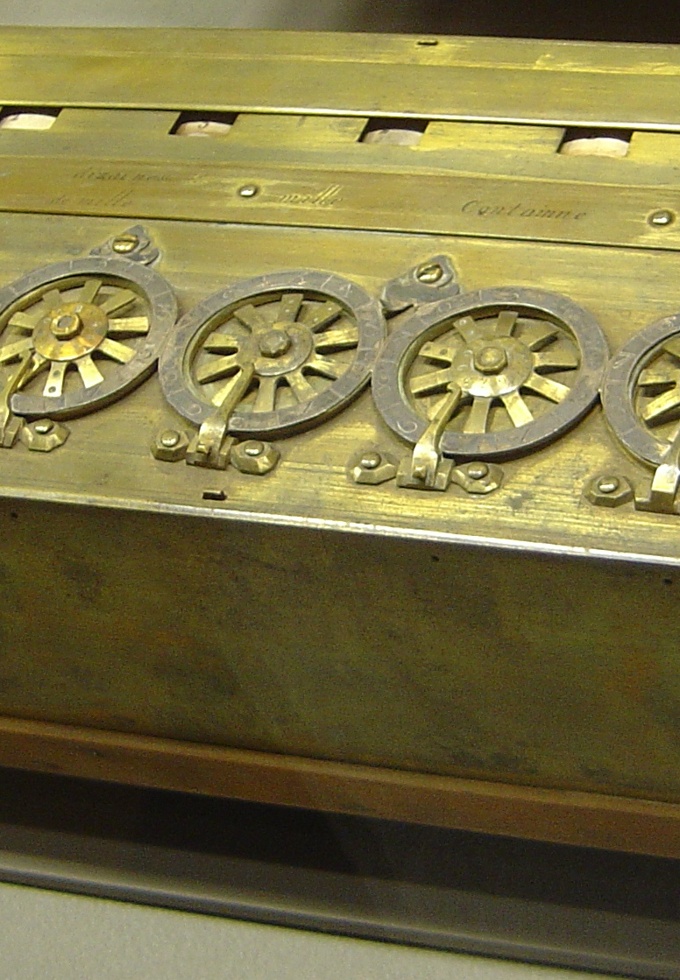

1642: Pascaline

La pascaline, initialement dénommée machine d’arithmétique, est la première machine à calculer mécanique. Inventée par Blaise Pascal, elle permettait d’additionner et de soustraire deux nombres d'une façon directe et de faire des multiplications et des divisions par répétitions. L'introduction de la pascaline marque le commencement du développement du calcul mécanique, qui passera des machines à calculer aux calculatrices électriques et électroniques jusqu’aux ordinateurs.

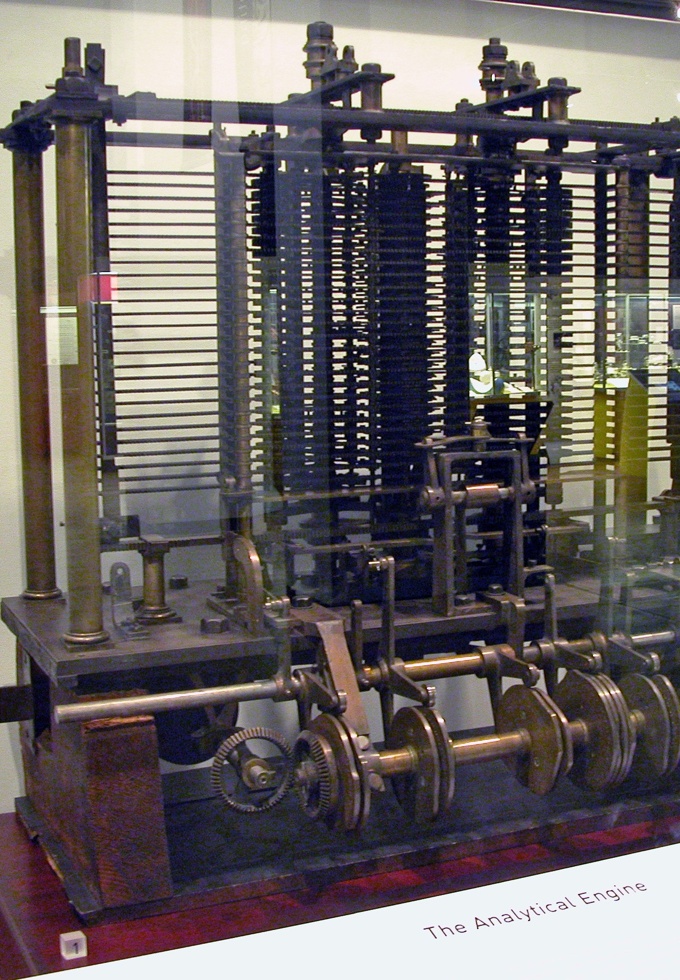

1834: Machine analytique de Babbage

La machine analytique est une machine à calculer programmable imaginée en 1834 par le mathématicien anglais Charles Babbage. Il ne la réalisera jamais (sauf pour un prototype inachevé), mais il passera le reste de sa vie à la concevoir dans les moindres détails. Le plus jeune de ses fils, Henry Babbage, en construira l'unité centrale et l'imprimante de 1880 à 1910. Ada Lovelace conçut les premiers programmes informatiques pour cette machine.

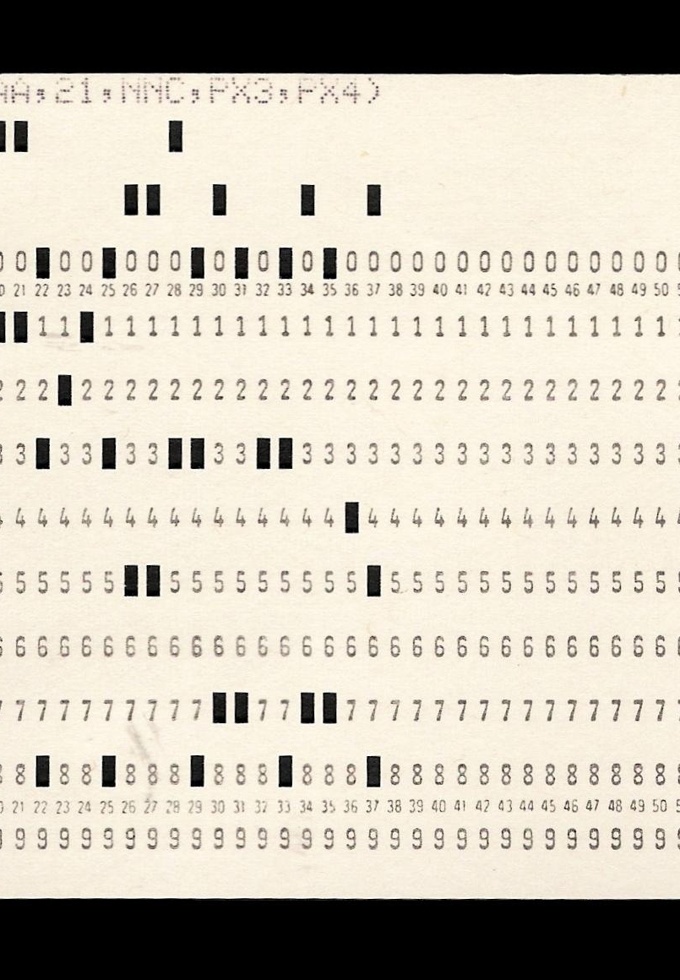

1889: Machine d’Hollerith

En réponse à un concours lancé par le Bureau américain du recensement, Hermann Hollerith construit une machine à cartes perforées de 12×6 cm ayant 210 cases pour recevoir toutes les informations requises. Brevetée en 1889, cette machine permet d’effectuer le recensement (auparavant manuel) de 1890 en six ans « seulement ». En 1896, Herman Hollerith quitte l'administration pour fonder la Computing-Tabulating-Recording Company, qui sera renommée par la suite en IBM.

1937: Premier additionneur binaire à relais

Appelé le modèle K Adder parce qu'il l'a construit sur sa table «Kitchen», ce simple circuit de démonstration fournit une preuve de concept pour l'application de la logique booléenne à la conception des ordinateurs. Stiblitz s’attelera ensuite à la construction de la calculatrice de nombre complexe basée sur relais. La même année en Allemagne, l'ingénieur Konrad Zuse a construit son ordinateur Z2, utilisant également des relais téléphoniques.

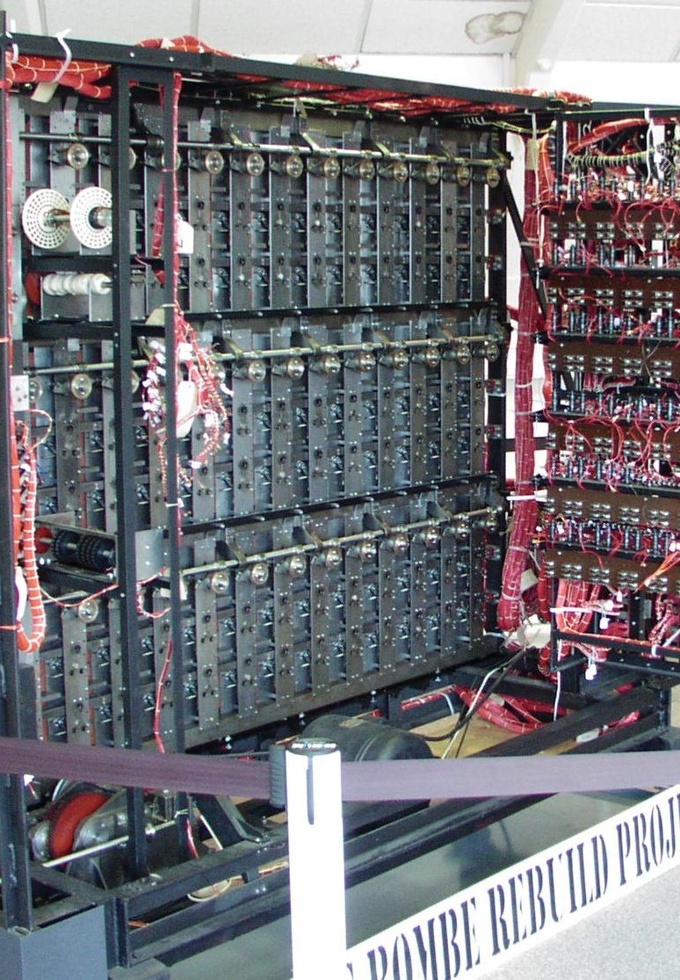

1938: Bombe (électromagnétique)

La Bombe est un instrument électromécanique qui fut utilisé par les cryptologues britanniques afin de casser les codes allemands d'Enigma pendant la Seconde Guerre mondiale. Conçue en 1938 par le cryptologue polonais Marian Rejewski, elle fut perfectionnée par Alan Turing et Gordon Welchman. Les Bombes ont été d'une importance vitale pour les Alliés et ont été largement créditées pour avoir contribué à raccourcir la durée de la guerre en Europe.

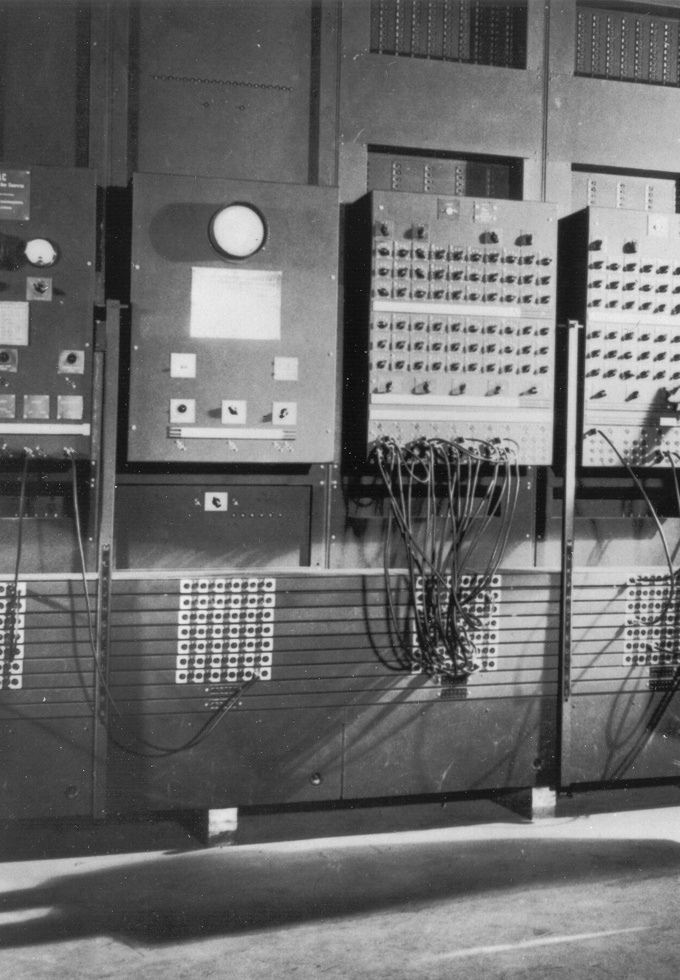

1945: ENIAC premier ordinateur

L'ENIAC, créé en 1945, est le premier ordinateur entièrement électronique et Turing-complet, c’est-à-dire pouvant être programmé pour résoudre, en principe, tous les problèmes de calcul numérique. Il a été précédé en 1941 par le Zuse 3 allemand, une machine programmable mais encore électromécanique (utilisation de relais), et par la série de calculateurs britanniques Colossus, électroniques mais non Turing-complets. L'ENIAC pouvait effectuer 5 000 opérations par seconde.

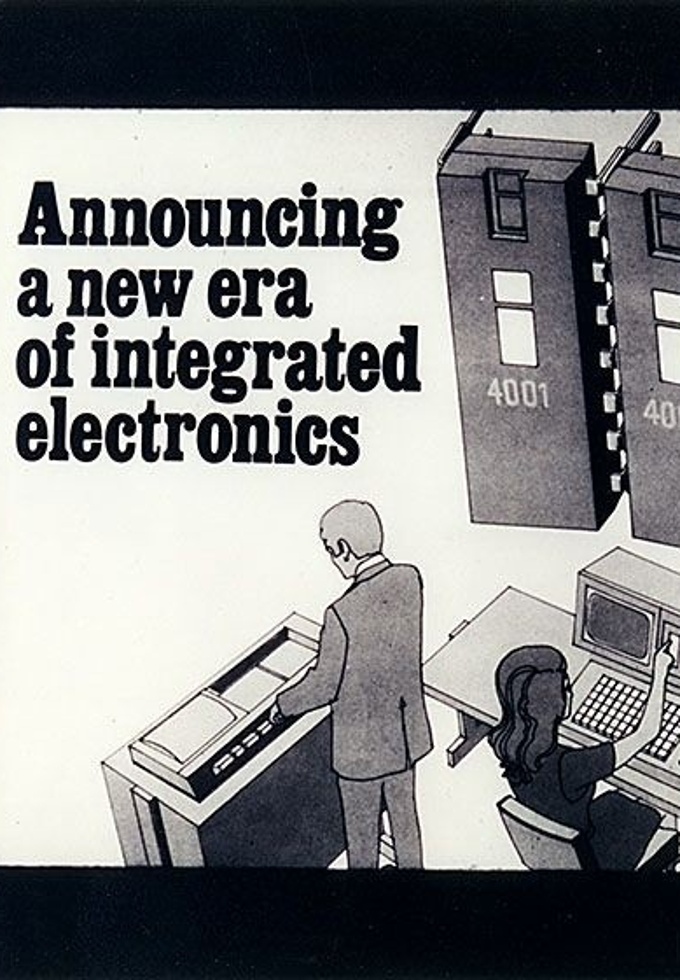

1971: Premier microprocesseur

La première annonce pour un microprocesseur, l'Intel 4004, apparaît dans Electronic News. Développé pour Busicom, un calculateur japonais, le 4004 avait 2250 transistors et pouvait effectuer jusqu'à 90 000 opérations par seconde en morceaux de quatre bits. Federico Faggin a dirigé le design et Ted Hoff a dirigé l'architecture.

1976: Supercalculateur CRAY-1

Le premier supercalculateur est le Cray-1 lancé en 1976. Son architecture spécialement conçue pour les calculs scientifiques était révolutionnaire. Il pouvait effectuer 160 millions d'instructions par seconde. Depuis lors, de nombreux supercalculateurs, toujours plus puissants, ont été conçus. A ce jour (2024), les plus rapides effectuent environ $10^15$ opérations par secondes. Ils sont largement utilisés dans la recherche scientifique, l'ingénierie, la modélisation climatique, la cryptographie...

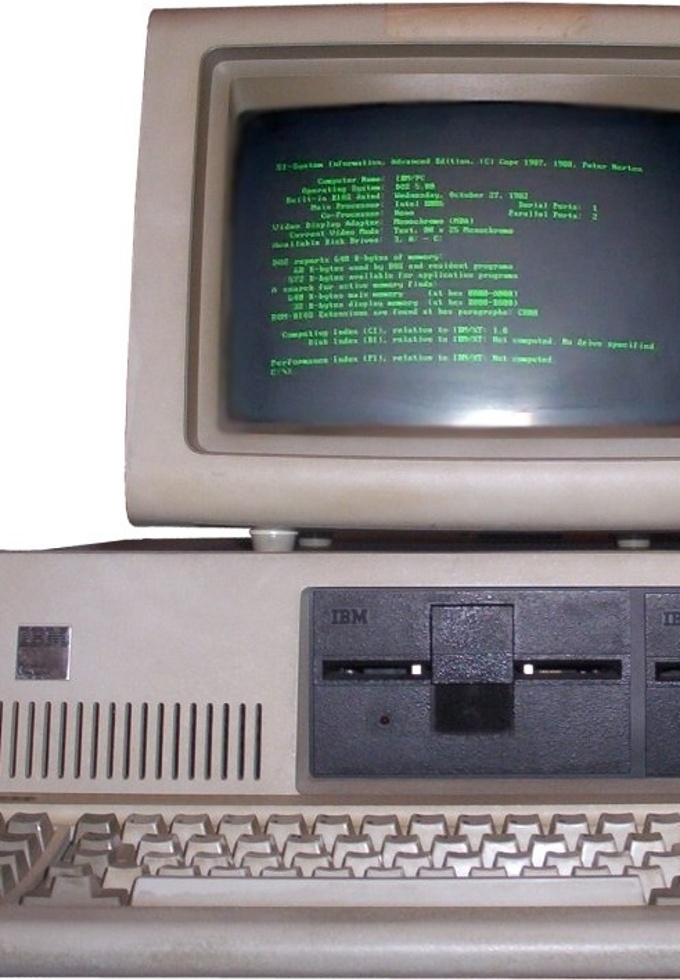

1981: IBM PC

L'annonce par IBM de son propre ordinateur personnel (PC) stimule la croissance rapide du marché des ordinateurs personnels. Le premier PC IBM, modèle IBM 5150, était basé sur un microprocesseur Intel 8088 de 4,77 MHz et a utilisé le système d'exploitation MS-DOS de Microsoft. Le PC IBM a révolutionné l'informatique commerciale en devenant le premier PC à obtenir une adoption généralisée grâce à son architecture ouverte qui en a fait l'ancêtre de tous les compatibles PC.

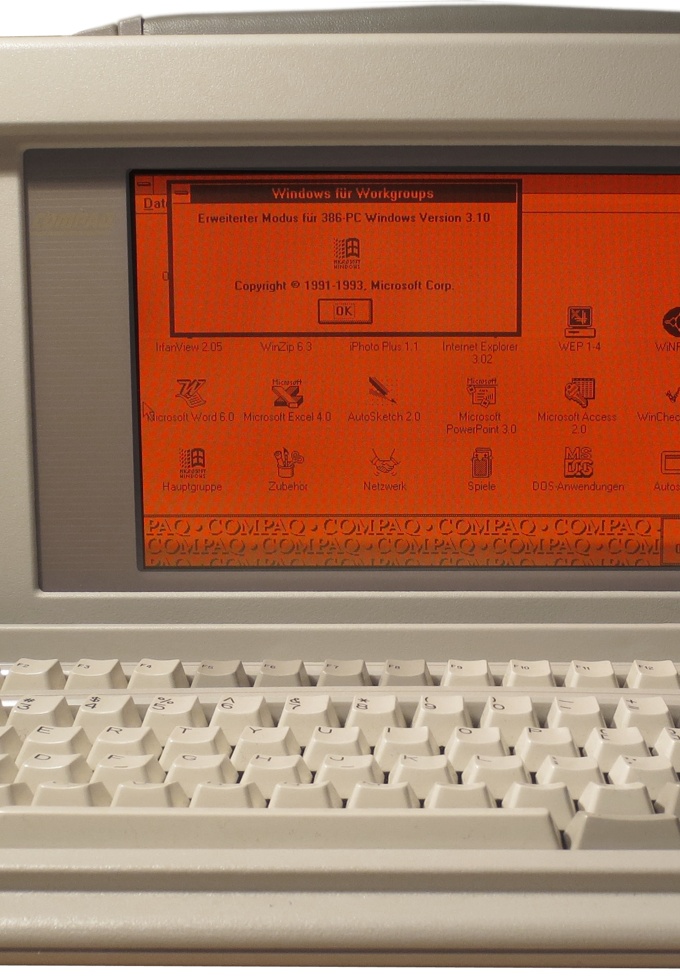

1983: Ordinateur portable

Les premiers prototypes d'ordinateurs portables ont été développés dans les années 1970, mais étaient encore trop lourds (> 20 kg). Dans les années 1980 des modèles plus légers sont apparus, comme le Compaq Portable, introduit en 1983, et l'IBM PC Convertible, lancé en 1986 qui ne pesaient qu’une dizaine de kilogrammes. Au fil des années 1990, les ordinateurs portables sont devenus plus compacts, plus légers, plus puissants et plus abordables, ce qui a contribué à leur adoption à grande échelle.

2007: Smartphone tactile

Le premier smartphone moderne est généralement considéré être l’IBM Simon Personal Communicator présenté en 1992. Cependant, les smartphones tels que nous les connaissons aujourd'hui, avec un système d'exploitation, des applications et un écran tactile, apparaissent en 2007 avec l'IPhone. Il est suivi l’année suivante par le BlackBerry Storm et l’Android HTC G1. Depuis lors, les smartphones ont connu une évolution rapide en termes de puissance, de fonctionnalités et d'ubiquité.

Mémoires

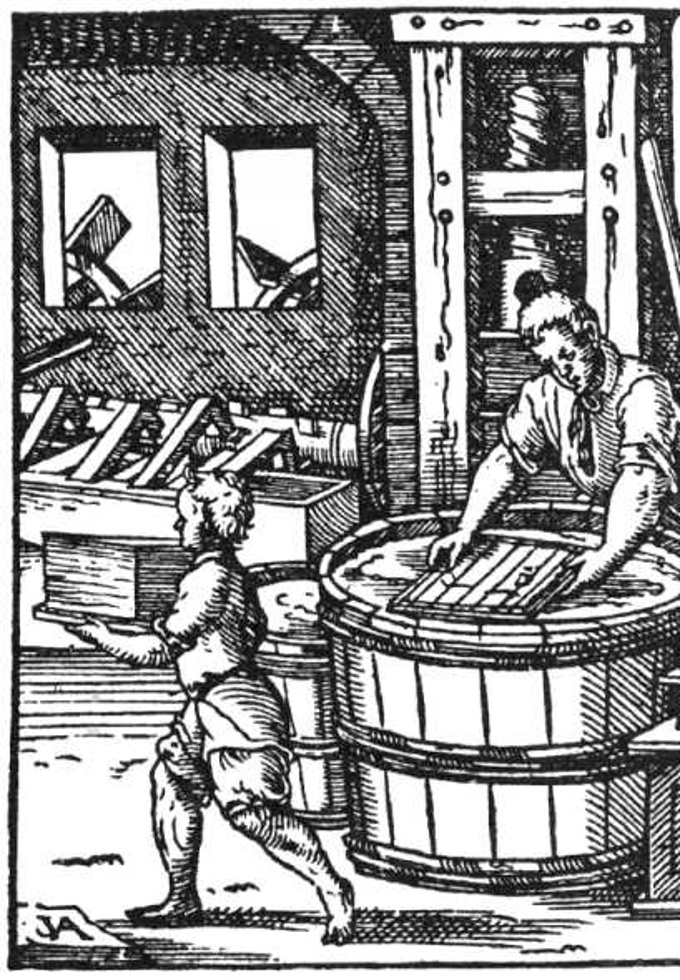

XIIe siècle

: PapierApporté en Europe par les Arabes au XIIe siècle, le papier s'est progressivement répandu, remplaçant les supports d'écriture antérieurs (parchemin, papyrus). L'imprimerie à caractères mobiles inventée par Gutenberg vers 1450 permet de reproduire rapidement et efficacement des textes sur papier. Elle a révolutionné la diffusion du savoir et de l'information.

1728: Cartes perforées

Reprenant l’idée de ruban perforé de Bouchon, Falcon met au point une série de cartes perforées reliées entre elles pour la programmation d’un métier à tisser. Jacquard l’intégrera dans son métier à tisser qui fut adopté dans le monde entier à partir de 1801. Les cartes perforées furent utilisées par les premières machines (de Babbage et d’Hollerith), puis par les ordinateurs jusque dans les années 1970 où elles disparurent au profit de système de stockage plus performants.

1947: Tube Manchester Mark I Williams-Kilburn

À l'Université de Manchester est développé le tube Williams-Kilburn. Le tube, est la première mémoire à grande vitesse entièrement électronique. Il a utilisé un tube cathodique (similaire à un tube d'image TV analogique) pour stocker des bits comme des points sur la surface de l'écran. Chaque point a duré une fraction de seconde avant de s'effacer, de sorte que l'information a été constamment rafraîchie. L'information a été lue par une plaque en métal qui détecte un changement de charge électrique.

1951: UNIVAC UNISERVO lecteur de bande

UNIVAC introduit le lecteur de bande "UNISERVO". C'était le premier dispositif de stockage de bande pour un ordinateur commercial, et la capacité hors ligne illimitée de bande magnétique le rend très populaire. Les bandes UNIVAC étaient de 1⁄2" de largeur, 0,0015" d'épaisseur, jusqu'à 1 500' de longueur, et faites de bronze de phosphore avec un revêtement métallique. Peser environ trois livres, chaque bobine pourrait contenir 1 440 000 chiffres décimaux et pourrait être lu à 100 pouces/sec.

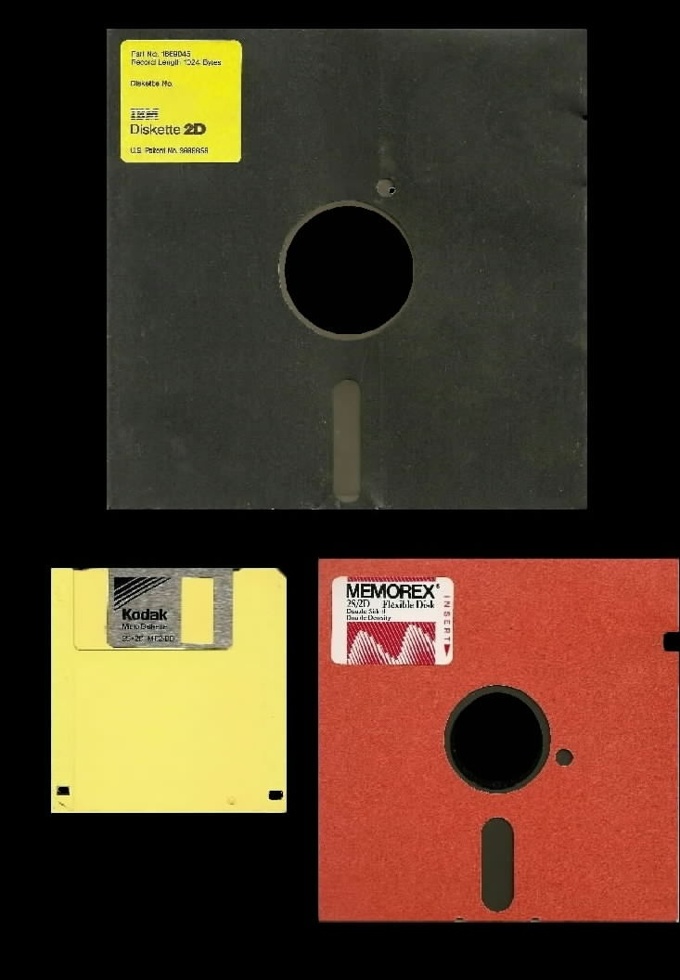

1968: Disquette

Une disquette est composée d'un fin disque de plastique souple renforcé en son centre sur lequel est apposé un substrat magnétique. Elles sont des supports de mémoire numérique plus légers et plus économiques que les tambours magnétiques ou les disques durs. La première génération, de 8 pouces et pouvant stocker 80 000 caractères. Finalement, les clés USB ont détrôné les disquettes au début des années 2000 en raison de leur plus grande capacité et de leur meilleure résistance.

1974: Carte à puce

Une carte à puce est une petite carte portant un circuit intégré capable de contenir de l'information. Le circuit intégré (la puce) peut contenir un microprocesseur capable de traiter cette information, ou être limité à des circuits de mémoire non volatile. Brevetée par le Français Roland Moreno, celui-ci apportera de nombreuses améliorations de sécurité notamment:

la comparaison interne du code confidentiel ;

la protection en lecture ou en écriture de certaines zones de la mémoire.

1977: Puces ROM

Lancement de la console de jeu Atari VCS, l'une des premières à utiliser des cartouches interchangeables avec des puces ROM programmées en usine. Contrairement à d'autres consoles, Atari a opté pour les cartouches, propulsant le VCS au statut de l'une des consoles les plus populaires de tous les temps.

1983: CD-ROM

Le CD-ROM est un petit disque optique révolutionnaire. Un laser balaie sa surface et interprète les variations de réflexion créées par des "trous" et "bosses" microscopiques. Cette technologie permet de stocker 700 Mo de données, une quantité énorme à l'époque, et de supplanter les disquettes limitées en capacité et fragiles. Il a marqué l'essor du multimédia en diffusant musique, films et jeux vidéo sur un seul support, puis a été dépassé par des formats plus modernes comme les DVD et clés USB.

1990: Centre de données

Un centre de données (en anglais data center) est un lieu (et un service) où sont regroupés des baies de stockages, des serveurs et des équipements réseaux. Il fournit un environnement sécurisé et contrôlé pour le stockage, la gestion et le traitement des données. Les data centers se sont généralisés et sont devenus gigantesques à partir des années 1990, avec l'explosion de l'Internet et la croissance exponentielle des données numériques.

1992: Module SSD

Un prototype de disque solide (SSD) est conçu pour être évalué par IBM. SanDisk, qui à l'époque était connu sous le nom de SunDisk, fabriquait le module qui utilisait des puces de mémoire non volatiles pour remplacer les disques tournants d'un disque dur. SanDisk a reconnu que les appareils portatifs et les ordinateurs devenaient plus légers et plus petits, et que la mémoire flash, telle qu'utilisée dans le module SSD, offrait de puissants avantages sur les disques durs.

2000: USB Clé USB

Les lecteurs flash USB, également appelés jump drives ou memory sticks, offrent un stockage rapide et de grande capacité grâce à leur mémoire flash et leur interface USB. Ils ont supplanté les disques optiques et les disquettes en raison de leur vitesse, de leur capacité accrue, et de leur résistance à l'effacement magnétique. Idéaux pour le stockage et le transfert de fichiers entre appareils, ils ont rapidement remplacé les anciens supports de stockage.

2016: Hébergement open-source de fichiers en ligne avec Nextcloud

Nextcloud est un logiciel libre de site d'hébergement de fichiers et une plateforme de collaboration. À l'origine accessible via WebDAV, n'importe quel navigateur web, ou des clients spécialisés, son architecture ouverte a permis de voir ses fonctionnalités s'étendre depuis ses origines. En 2020, il propose de nombreux services.

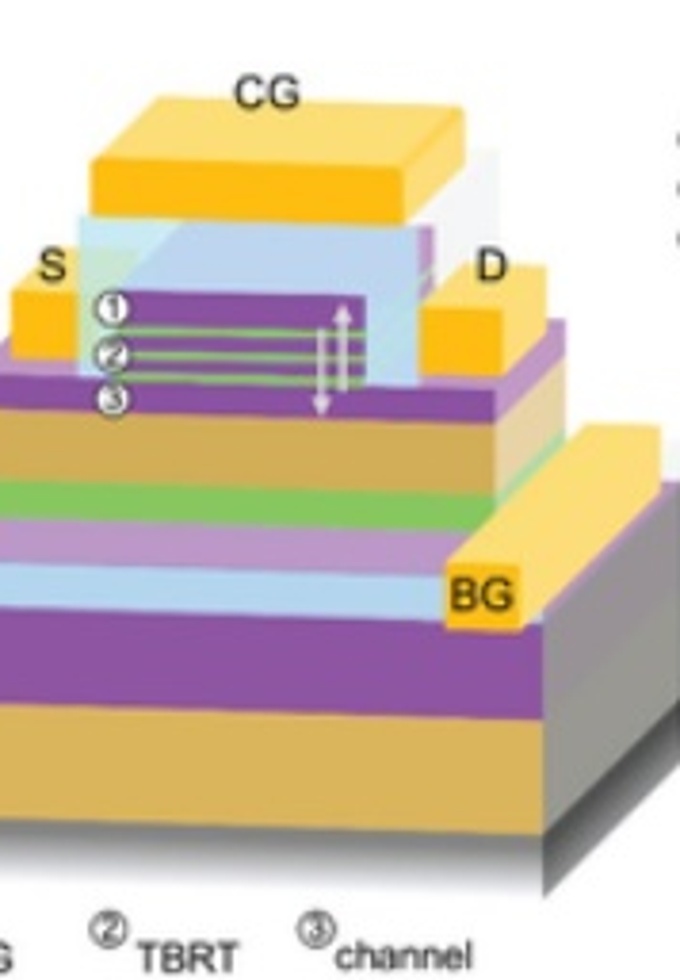

2022: ULTRARAM

ULTRARAM, une mémoire non volatile, offre un stockage ultrarapide et économe en énergie sur un substrat Si, ouvrant la voie à une production de masse abordable. Les cellules individuelles démontrent une transition logique rapide après des impulsions de programmation/effacement de ≤10 ms à ≈2.5 V, avec une consommation d'énergie bien inférieure à celle de la mémoire vive dynamique et de la mémoire flash pour une taille de cellule donnée.

Culture populaire

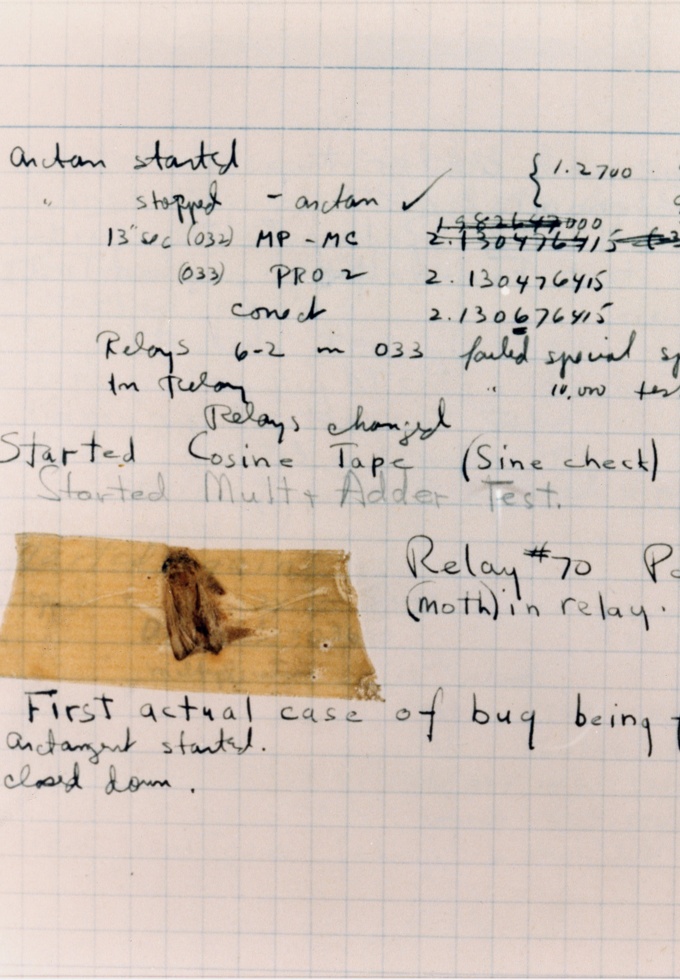

1947: Premier cas de bug

Un bug (mot anglais \emph{bug}) ou bogue est un défaut de conception d'un programme à l'origine d'un dysfonctionnement. Le terme a été utilisé la première fois par Grace Hopper quand un papillon avait bloqué son ordinateur Harvard Mark II.

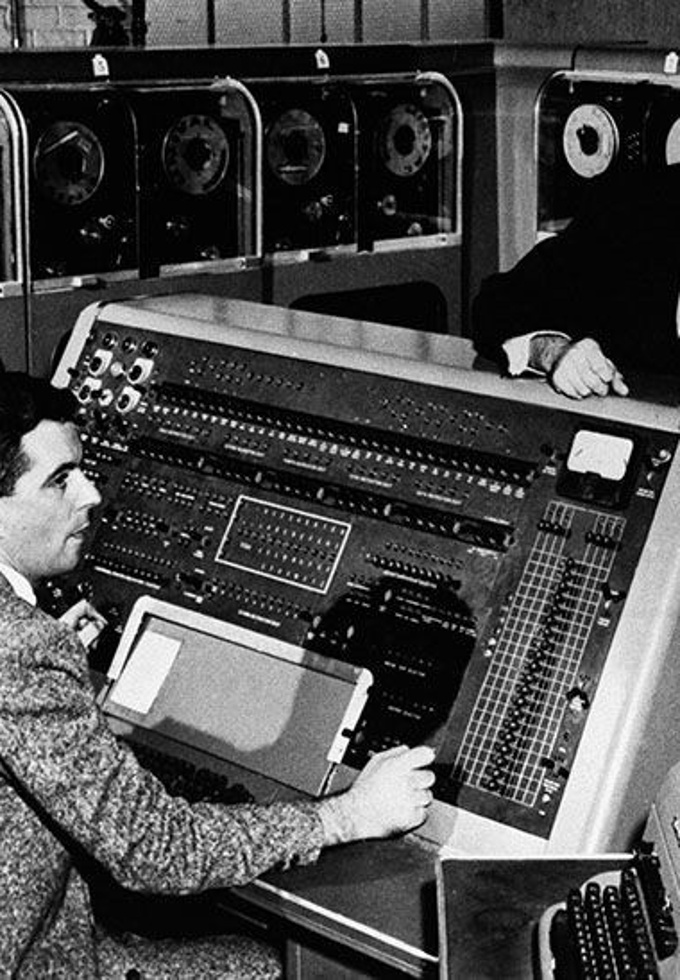

1952: L'ordinateur d'UNIVAC prédit l'élection

Le soir des élections, CBS News emprunte un ordinateur UNIVAC pour prédire le résultat de la course à la présidence américaine entre Dwight D. Eisenhower et Adlai Stevenson. Les sondages d'opinion prédisaient un fort soutien pour Stevenson, mais l'analyse d'UNIVAC sur les premiers retours montrait une victoire nette pour Eisenhower. Cette forte divergence a amené les dirigeants de l'UNIVAC à remettre en question la validité des prévisions de l'ordinateur.

1968: 2001 : Une Odyssée de l'Espace

2001 l’odysée de l’espace raconte l'histoire de l'ordinateur HAL 9000 pendant la Découverte Le voyage d'un vaisseau spatial à Jupiter pour enquêter sur un mystérieux signal. L'ordinateur HAL 9000 qui contrôlait tous les aspects des opérations navales, a tué l'équipage étant transporté en stase, et a finalement été arrêté par le seul membre d'équipage survivant.

1978: Premiers ordinateurs installés à la Maison Blanche

Alors que le gouvernement américain avait financé de nombreux projets informatiques datant des années 1940, ce n'est qu'à l'administration Carter qu'un ordinateur est installé à la Maison Blanche. On a donné aux employés des terminaux pour accéder à un ordinateur Hewlett-Packard HP3000 partagé, et le département de technologie a acquis un Xerox Alto pour le bureau ovale.

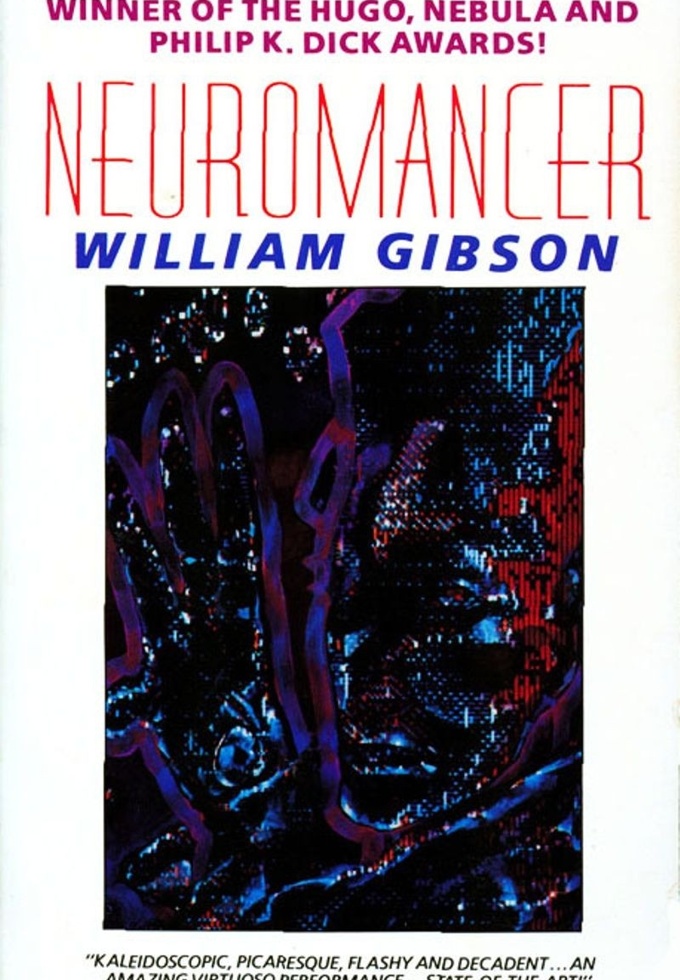

1984: Terme «cyberespace» inventé

Dans son roman Neuromancer, William Gibson signe le terme « cyberespace ». Gibson a également engendré un genre de fiction connu sous le nom de "cyberpunk" dans son livre, qui décrit un avenir sombre et complexe rempli de machines intelligentes, de virus informatiques et de paranoïa.

1993: Jurassic Park sorti

L'histoire du réalisateur Steven Spielberg sur les dinosaures ressuscités, Jurassic Park, devient le film le plus gros jusqu'à présent. Basé sur un roman de Michael Crichton, Jurassic Park a raconté l'histoire d'un groupe de visiteurs sur une île où les dinosaures sont déclenchés pour courir dans un parc d'attractions inachevé. Pour créer des dinosaures réalistes, l'équipe de Spielberg a combiné l'animation, la marionnette et l'animation informatique de pointe.

2009: Bitcoin

Satoshi Nakamoto, probablement un pseudonyme, publie Bitcoin: Un Peer-to-Peer Electronic Cash System, décrivant l'utilisation des réseaux peer-to-peer pour générer un crypto-monnaie. Dans le système Bitcoin, les utilisateurs exécutent un logiciel qui recherche des blocs de données, dont la découverte récompense les utilisateurs avec Bitcoins. La transaction est enregistrée sur le système même si l'information utilisateur est privée. Ils peuvent alors être utilisés en ligne.

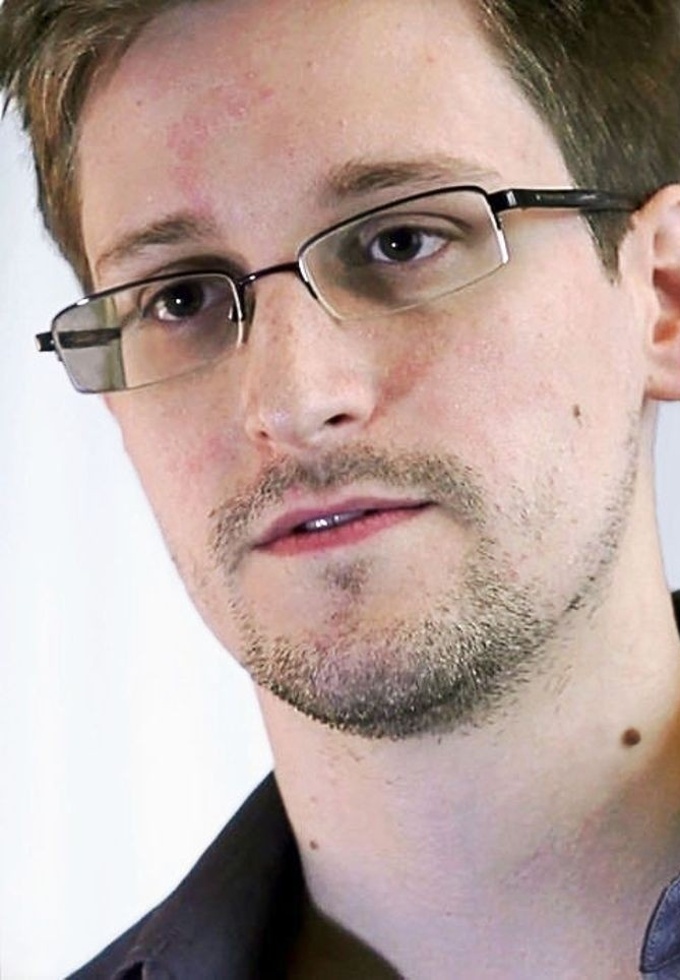

2013: Edward Snowden

Edward Snowden, ancien employé de la CIA et entrepreneur de la NSA, a copié des centaines de milliers de documents de programmes de sécurité nationale américains confidentiels. Snowden a travaillé avec des journalistes aux États-Unis et au Royaume-Uni pour mettre en lumière les programmes. Parmi les programmes exposés par Snowden les révélations étaient PRISM, où la NSA a recueilli des données avec l'aide d'entreprises telles que Microsoft, Facebook, et Google.

2017: \#MeToo

Le journaliste Harvey Weinstein a été accusé de harcèlement sexuel. Cette affaire a fait l'objet d'un mouvement sur les réseaux sociaux appelé #MeToo qui a conduit à une nouvelle culture visant à prendre en compte les problèmes d'exploitation et de discrimination sexuels dans le monde des médias et du travail.

Robots

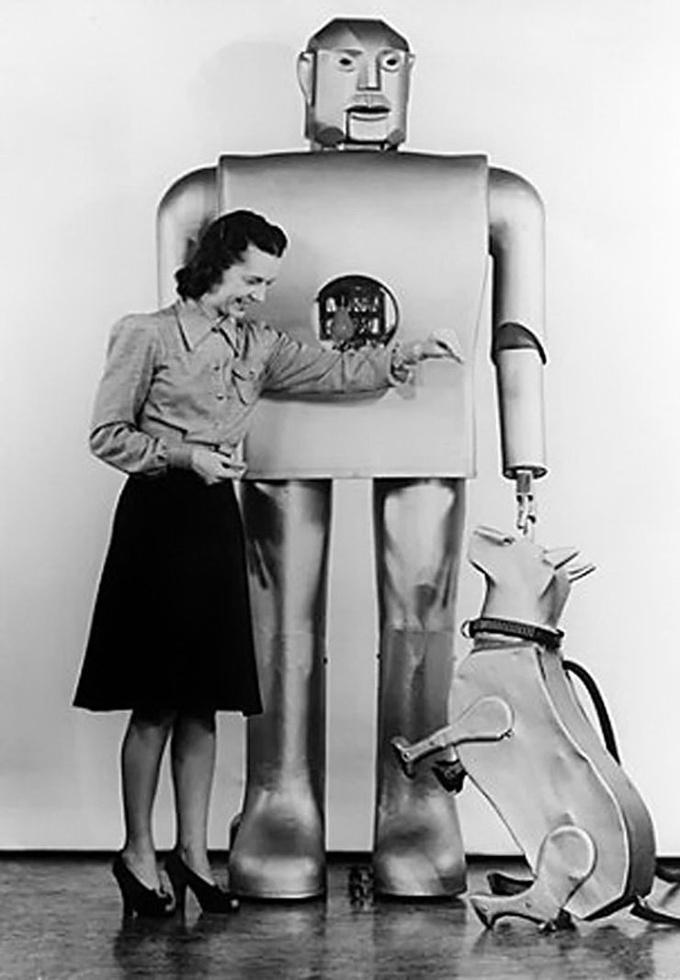

1939: Elektro à l'Exposition Mondiale

Construit par Westinghouse, le robot Elektro à relais répond au rythme des commandes vocales et délivre des sagecracks préenregistrés sur des disques 78 tr/min. Il est apparu à l'Exposition Mondiale, et il pouvait bouger la tête et les bras... et même des cigarettes « fumées ».

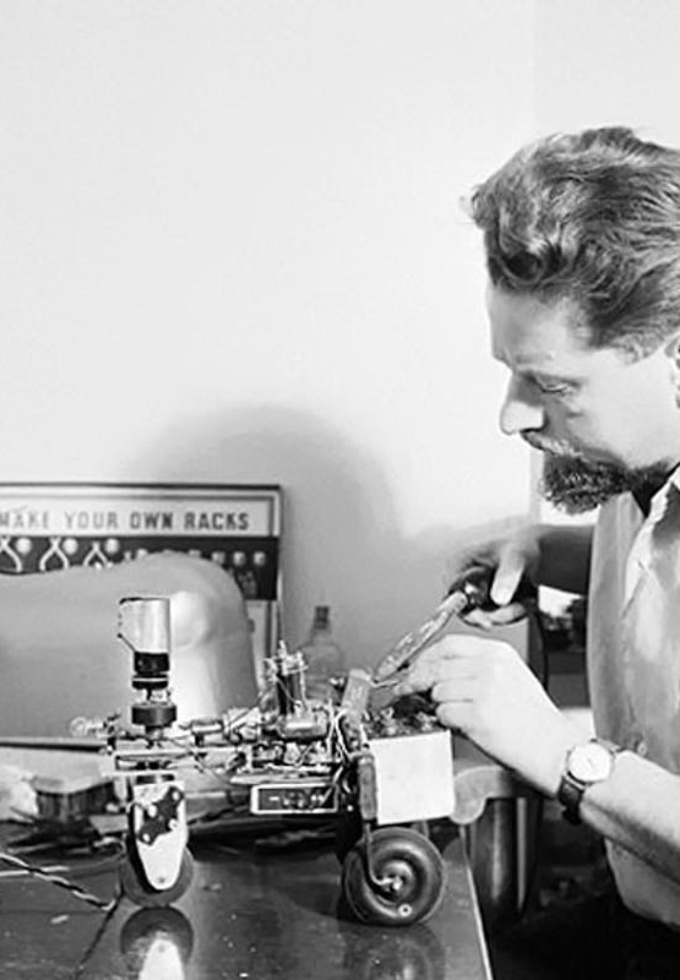

1950: Grey Walter's Elsie

Un neurophysiologiste, Walter a construit des automates à roues afin d'expérimenter le comportement de recherche de but. Son robot le plus connu, Elsie, a utilisé des cellules photoélectriques pour rechercher une lumière modérée tout en évitant la lumière forte et l'obscurité, ce qui l'a particulièrement attirée par les bas des femmes.

1961: UNIMATE

UNIMATE, le premier robot industriel de série, commence ses travaux chez General Motors. Obéissant aux commandes étape par étape stockées sur un tambour magnétique, le bras robotisé de 4 000 livres séquencé et empilé des morceaux chauds de métal moulé sous pression. UNIMATE était le cerveau de Joe Engelberger et George Devol, et à l'origine automatisé la fabrication de tubes d'images TV.

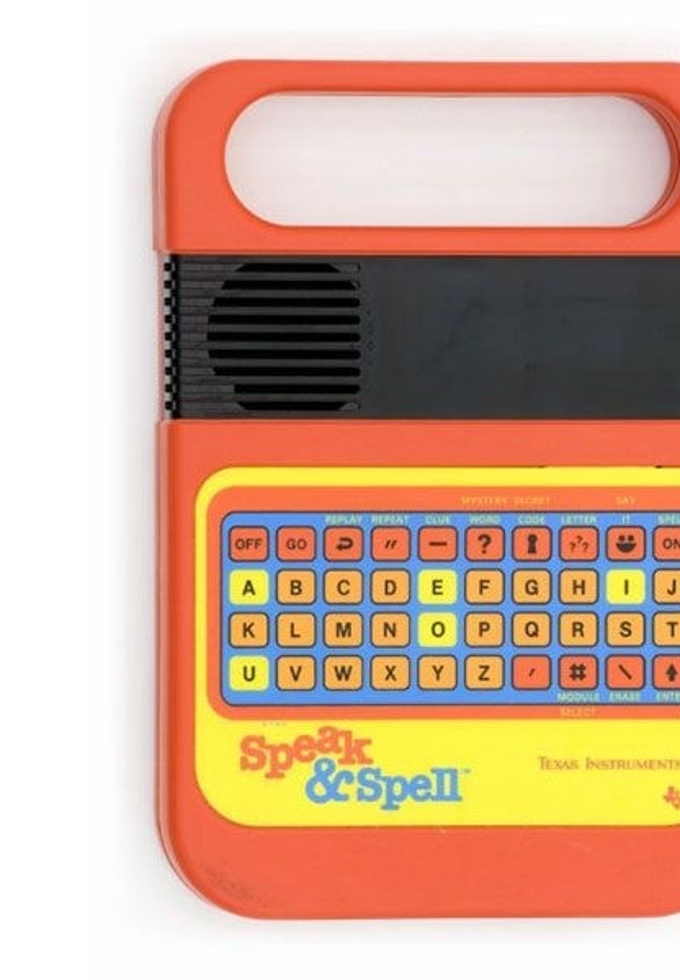

1978: Speak and Spell

Texas Instruments lance Speak et Spell, une aide à l'apprentissage pour enfants. Pionnier de la duplication électronique du tract vocal humain sur un seul circuit intégré, Speak et Spell utilise le codage prédictif linéaire pour créer un modèle mathématique du canal vocal humain. En utilisant l'entrée précédente, il prédit un échantillon de parole, transformant ainsi l'information numérique en langage synthétique. Il peut stocker plus de 100 secondes de sons linguistiques.

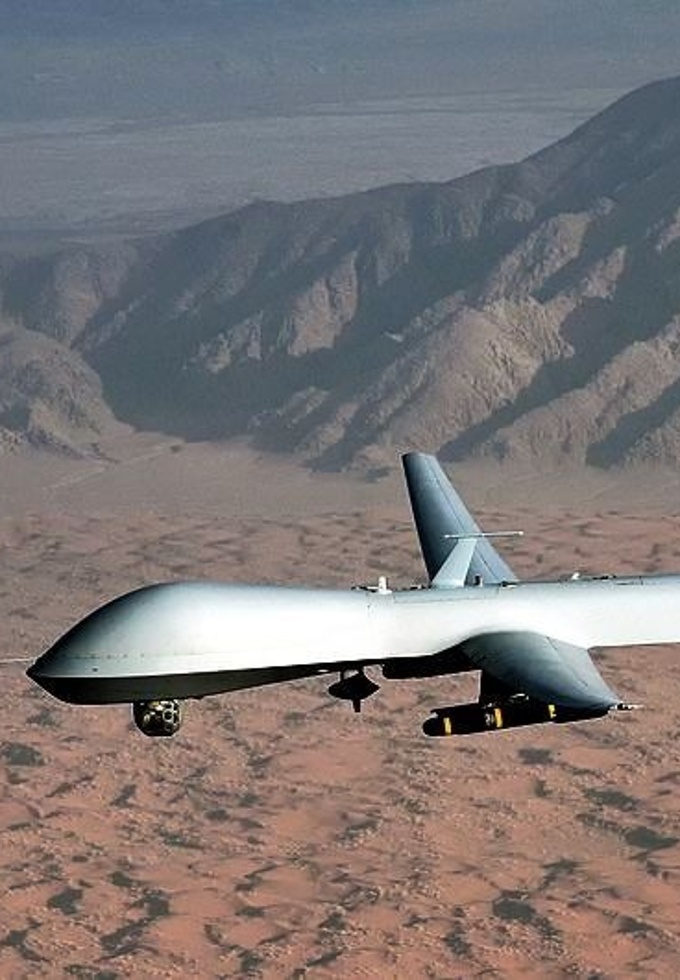

1995: Le drone Predator MQ-1

Le drone Predator MQ-1 est introduit et mis en œuvre par l'Aviation américaine et la Central Intelligence Agency. Il a été largement utilisé en Afghanistan et dans les zones tribales pakistanaises contre les forces d'Al-Qaïda et les militants talibans depuis l’attaque terroriste du 11 septembre. Les véhicules aériens sans pilote étaient équipés de caméras de reconnaissance et pouvaient être modernisés pour transporter deux missiles.

2000: Robot humanoĩde ASIMO

Le robot humanoïde HondaS Advanced Step in Innovative Mobility (ASIMO) est introduit. Il pouvait marcher 1 mi/h, monter des escaliers et changer de direction après avoir détecté les dangers. En utilisant la caméra montée dans sa tête, l'ASIMO pourrait également reconnaître les visages, les gestes et les mouvements de plusieurs objets. De plus, l'ASIMO avait des microphones qui lui permettaient de réagir aux commandes vocales. Environ 100 ont été construits.

Logiciels

1945: Plancalkül (Plan Calcul)

Konrad Zuse commence les travaux sur Plankalkül (Plan Calcul), le premier langage de programmation algorithmique, dans le but de créer les conditions théoriques pour la solution de problèmes généraux. Auparavant, Zuse avait développé et construit le premier ordinateur numérique binaire, le Z1. Il a terminé le premier ordinateur numérique électromécanique entièrement fonctionnel, le Z3. Seul le Z4 — le plus sophistiqué de ses créations — a survécu à la Seconde Guerre mondiale.

1952: Grace Hopper complète A-0

Le mathématicien Grace Hopper complète A-0, un programme qui permet à un utilisateur d'utiliser des mots de type anglais au lieu de nombres pour donner les instructions de l'ordinateur. Il possédait plusieurs caractéristiques d'un compilateur moderne et a été écrit pour l'ordinateur UNIVAC I, le premier système informatique commercial aux États-Unis.

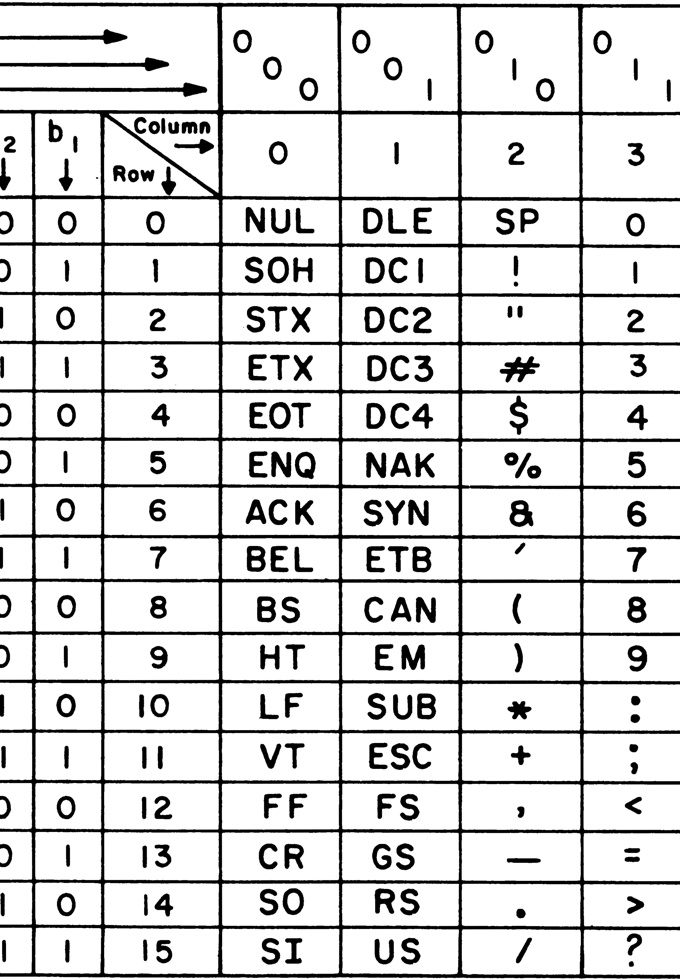

1963: Encodage ASCII

ASCII(American Standard Code for Information Interchange) permet aux machines de différents fabricants d'échanger des données. Le code ASCII comprenait 128 chaînes uniques de un et de zéro, par exemple le code ASCII de la lettre A est 1000001. Chaque séquence représentait une lettre de l'alphabet anglais, un chiffre et de symboles de ponctuation. Il a fini par être remplacé par Unicode, qui peut représenter plus de 100 000 symboles de tous les alphabets.

1972: Le langage de programmation C est publié

Le langage de programmation C est publié. Dennis Ritchie et son équipe ont créé C sur la base de la langue antérieure BCPL (Basic Combined Programming Language) et peu après ont re-écrit le code source pour Unix en C. C est encore largement utilisé aujourd'hui.

1983: Richard Stallman développe GNU

Richard Stallman, programmeur au laboratoire d'intelligence artificielle du MIT, a entrepris de développer une alternative gratuite au système d'exploitation Unix. Ce système d'exploitation appelé GNU (pour Gnu's Not Unix) allait être gratuit mais aussi permettre aux utilisateurs de changer et de le partager. Stallman a fondé la Free Software Foundation (FSF) sur la base de cette philosophie en 1985.

1991: Python

Alrs qu'il travaillait au développement du langage de programmation ABC aux Pays-Bas, le programmeur Guido van Rossum profite d'une semaine de vacances, et utilise son ordinateur personnel pour écrire la première version du langage. Fan de la série télévisée Monty Python's Flying Circus, il décide de baptiser ce projet Python. Python est un langage de programmation qui peut s'utiliser dans de nombreux contextes et permet une initiation aisée aux concepts de base de la programmation.

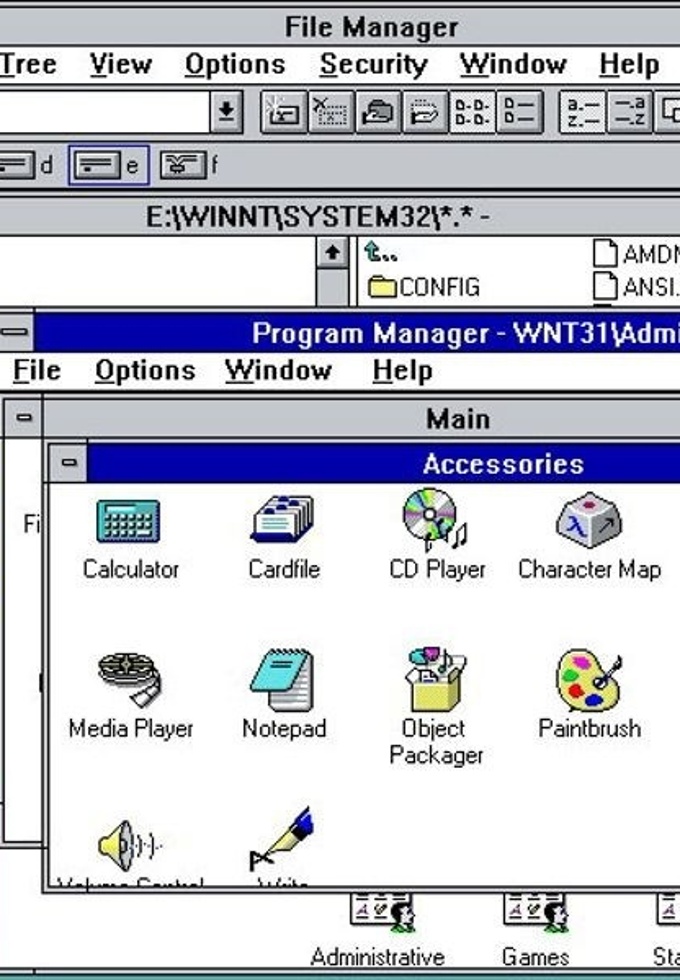

1993: Microsoft Windows NT est publié

Microsoft Windows NT est publié. Les travaux sur le projet ont débuté dans le cadre d'un effort mené par un groupe d'anciens employés de Digital Equipment Corporation dirigé par Dave Cutler. C'était la première version vraiment 32-bit de Windows de Microsoft, qui l'a rendu attrayant pour les utilisateurs d'ingénierie haut de gamme et scientifiques qui ont exigé de meilleures performances. Plusieurs versions ultérieures de Windows étaient basées sur la technologie NT.

2007: Scratch est publié

Scratch est diffusé au public. Language de programmation gratuite axé sur l'éducation, il a été conçue par une équipe dirigée par Mitchel Resnick au sein du MIT. Il a eu un certain nombre d'applications dans les milieux éducatifs. Son interface a permis aux utilisateurs débutants de stocker et d'organiser des commandes de blocs pour écrire des programmes. Scratch compte des millions d'utilisateurs dans le monde et est disponible en plus de 40 langues.

2011: Android 4.0

Sortie de Android 4.0 Ice Cream Sandwich, une nouvelle version de son système d'exploitation mobile qui offrait de nouvelles fonctionnalités telles qu'une nouvelle interface graphique et l'assistant personnel. Cet événement marque un tournant dans la culture informatique et les méthodes d'utilisation des logiciels sur les smartphones et tablettes.

2020: Tensorflow 2.x

TensorFlow est un outil open source d'apprentissage automatique. TensorFlow est l'un des outils les plus utilisés en IA dans le domaine de l'apprentissage machine.

Réseaux et web

1933: Le réseau de messagerie télex est en ligne

Telex commence comme un moyen de distribuer des messages militaires, mais devient bientôt un réseau mondial de messages qui persistera dans certains pays dans les années 2000. Telex utilise des téléimprimeurs, qui remontent aux années 1910 pour la télégraphie. Mais au lieu d'utiliser des lignes télégraphiques dédiées, le système télex relie ces téléimprimeurs les uns aux autres par des lignes téléphoniques vocales, acheminées par des commutateurs téléphoniques modifiés.

1949: Naissance du Modem

Développé pour la transmission de signaux radars, le modem module les données numériques en sons et les démodules reçoivent des sons en données numériques. (MODulation + DEModulation = MODEM). En permettant aux ordinateurs d'utiliser des lignes téléphoniques vocales normales, ils offrent une plus grande couverture et des coûts moins élevés que les lignes de télégraphe ou de données louées.

1958: Lignes téléphoniques numériques

Les compagnies de téléphone développent la transmission numérique à des fins internes – en particulier pour lancer plus d'appels sur chacune des lignes principales reliant leurs propres centres de commutation. Dans les années 1980, les compagnies de téléphone loueront des lignes numériques à des clients commerciaux.

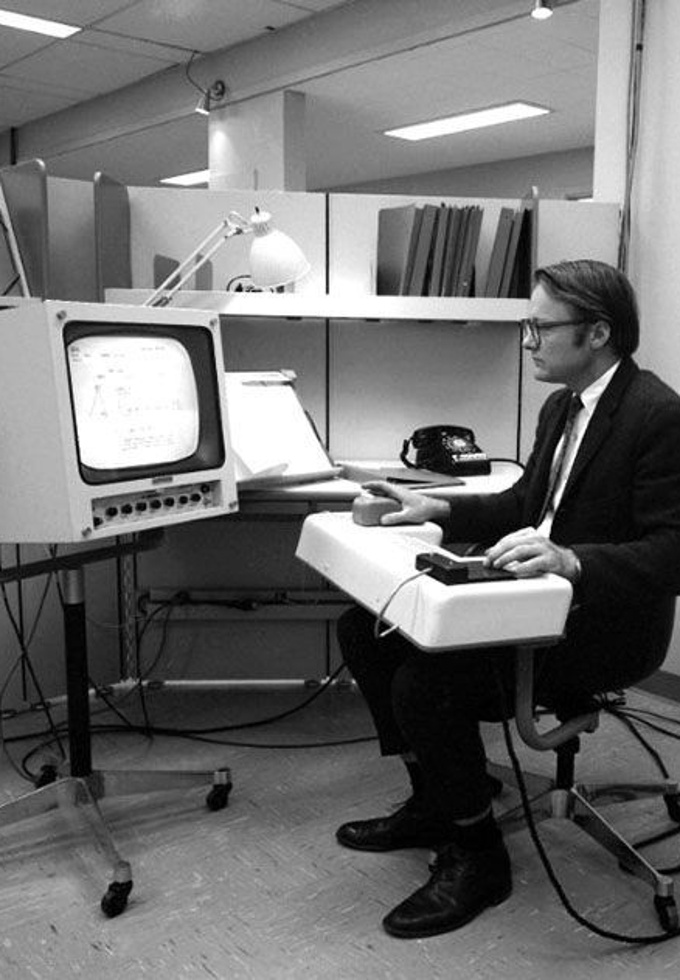

1968: «La Mère de toutes les Démos»

Douglas Engelbart dévoilent leur «oNline System» lors d'une conférence informatique à San Francisco dans ce qui deviendra la «mère de toutes les démos». Pendant 1h30, l'auditoire stupéfait d'environ un millier de témoins a collaboré à l'édition, à la visioconférence, au traitement de texte et à un étrange dispositif pointeur appelé « souris ». Chaque paragraphe ou autre élément du système NLS peut être lié à d'autres éléments en utilisant des liens hypertextes.

1971: E-mail

L'email fait le saut vers les nouveaux réseaux informatiques. Soudain, les messages sont libres de voyager partout où le réseau va, et l'email explose. Ray Tomlinson, de Bolt, Beranek et Newman, choisit le signe maintenant-iconique ..@.. pour son protocole d'email en réseau sur ARPAnet et en 1973, bien plus de 50% du trafic sur ce réseau axé sur la recherche est l'email.

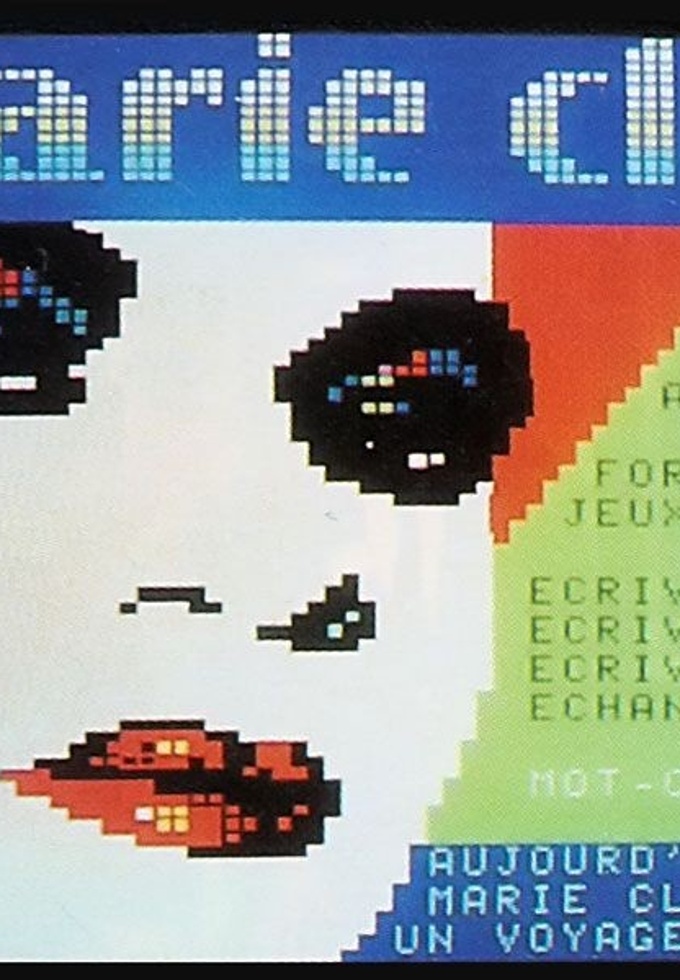

1981: Minitel

Gratuit ! C'est souvent un moyen efficace d'attirer les clients. France Telecom propose des terminaux Minitel gratuits à chaque abonné téléphonique, lançant la première série de sites web. Minitel aura des dizaines de millions d'utilisateurs d'ici 1990 et des services en ligne tels que les journaux, les horaires de train, les déclarations de taxes, les petites annonces érotiques ainsi que le courriel et le chat

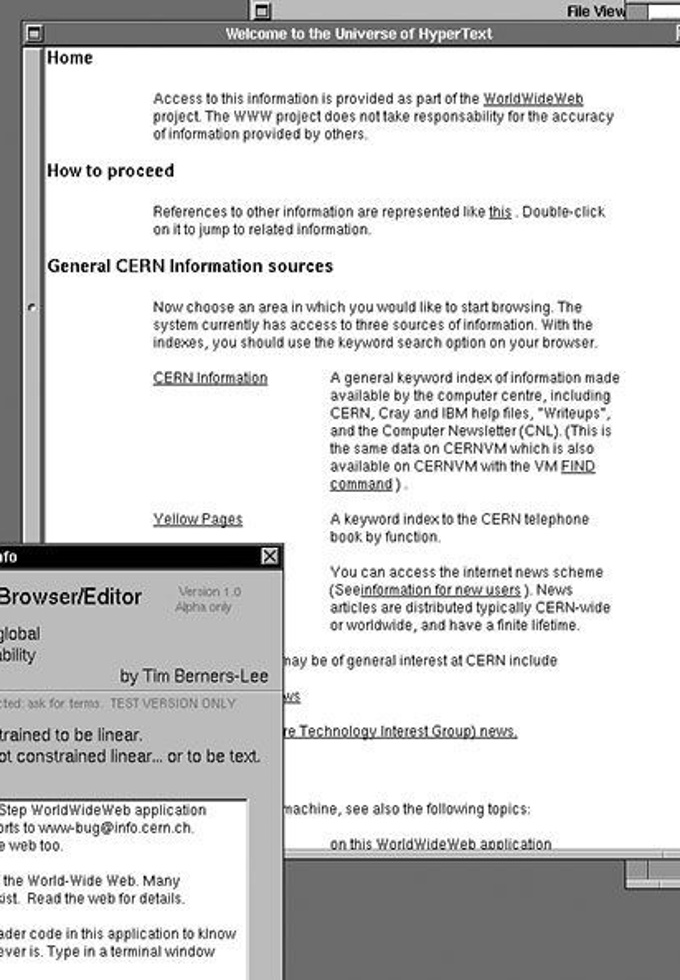

1990: World Wide Web

Au plus grand laboratoire de physique du monde, le CERN en Suisse, Tim Berners-Lee présente deux propositions pour ce qui deviendra le Web. Il a mis au point le prototype de WorldWideWeb en seulement trois mois sur un ordinateur NeXT avancé. Il dispose d'un serveur, HTML, URLs, et le premier navigateur. Le Web s'était inspiré en partie de son programme précédent Enquire, qui avait combiné l'hypertexte en réseau avec des idées qui évolueraient plus tard dans le Web sémantique.

2004: Internet 2.0

Le concept original du Web, et de nombreux systèmes pré-Web, dépendaient fortement des contributions des utilisateurs. Pourtant, de nombreux sites Web étaient plus comme la télévision ou la radio traditionnelle, les fournisseurs alimentant le contenu des surfeurs passifs Un certain nombre de sites commencent à aider les utilisateurs à générer et à façonner des contenus : wikis, blogs, réseaux sociaux, etc.

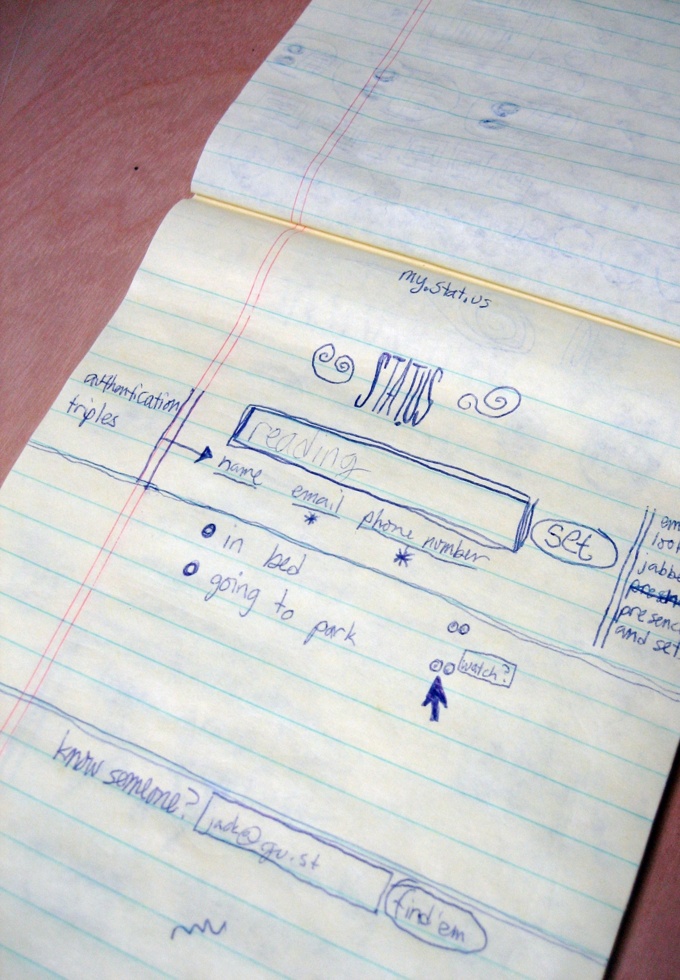

2006: Premier tweet

Jack Dorsey a envoyé le premier tweet sur le réseau social Twitter. Cet événement marque le début de l'ère des réseaux sociaux et la façon dont ces derniers ont changé la manière d'interagir et d'accéder à l'information sur le web.

Don't tech your time: Le jeu de cartes

Don't tech your time: Le jeu de cartes